# CoMi V2.0.2环境准备指导手册

北京致远互联软件股份有限公司

2026年2月

# 前言

本手册对致远新一代智能体产品家族CoMi V2.0、V2.0.1、V2.0.2版本服务器环境准备相关事宜进行说明,如对本手册中相关内容存在疑问,请与致远互联的客户服务人员联系。

CoMi V2.0、V2.0.1、V2.0.2版本的关系和选择:同属V2.0系列,小版本号越大功能越丰富,通常建议选择最新版本。CoMi支持的协同OA版本相同,原CoMi V2.0等老版本也可以平滑升级到CoMi最新版本。

CoMi支持对接V5产品线(A8、G6、A8N、G6N)和V8云原生产品线(A9C),对接这两种不同产品线所需部署的服务不同,详细细节在本手册后续内容中说明。

服务器环境准备视频讲解,可访问《CoMi飞书知识库环境资源准备 (opens new window)》查看。

# 版本变化

CoMi V2.0.2是V2.0.1的一个迭代版本,完善和新增了几个功能:

CoMi V2.0.2对协同OA版本要求与CoMi V2.0、V2.0.1相同!

- 迭代更新功能特性见《CoMi V2.0.2迭代飞书知识库 (opens new window)》

- CoMi2.0.2一体化部署工具新增卸载服务的功能

- CoMi2.0.2一体化部署工具新增自动写入生成Nginx配置功能,前提要求:按照[开放平台-Nginx相关手册 (opens new window)]进行NG部署和配置的V5产品线环境

- CoMi2.0.2一体化部署工具支持CoMi 2.0、CoMi 2.01升级到CoMi2.0.2

- 新增文件解析服务,需要和AI-Manager在同一个服务器上

- 新增沙箱,需要和AI-Engine在同一个服务器上

- 新增图片OCR服务,支持解析图片和扫描件,需要GPU环境

- 智能问数产品-协同驾驶舱高级版同步发布BI V3.2版本,适配CoMi V2.0.2,相关变更、手册、版本对应说明见《协同驾驶舱高级版V3.0系列资料清单 (opens new window)》

CoMi V2.0.1是V2.0的一个小迭代版本,以完善功能为主:

CoMi V2.0.1对协同OA版本要求与CoMi V2.0相同!

- 迭代更新功能特性见《CoMi V2.0.1迭代飞书知识库 (opens new window)》

- CoMi V2.0.1对服务器资源的要求、大模型要求、部署模式无变化,与CoMi V2.0一致

- 安装程序侧:产品提供CoMi V2.0升级到CoMi V2.0.1通路,详见2.0.1部署手册-升级章节

- CoMi V2.0.1版本支持的协同OA版本(与CoMi V2.0对比)无变化,OA侧无需打额外补丁,商务加密狗插件无变化

- CoMi V2.0.1版本支持的智能问数协同驾驶舱高级版版本为Bi V3.0 或 BI V3.1,两个BI版本均可使用

- CoMi V2.0.1版本支持在线更改工具地址,项目上将CoMi从测试环境协同连接切换到生产环境协同地址变得简单,详见2.0.1部署手册-修改Nginx内网地址章节

CoMi V2.0相比上个版本(CoMi V1.1)新增如下特性:

- 新增协同知识智能问答,新特性依赖协同全文检索服务向CoMi推送文档数据

- 向量知识库搜索新增全文检索、混合检索特性,新特性依赖ReRank模型进行检索重排序

- 新增Workflow工作流编排智能体

- 新增向导式安装部署工具,只需一台可以SSH到服务器的客户端电脑即可执行安装部署、启停、配置修改

- 新增CoMi Server APP服务,如使用CoMi移动APP,需要部署此服务,并且后续的前端代码也放置在该工程下

# CoMi环境准备

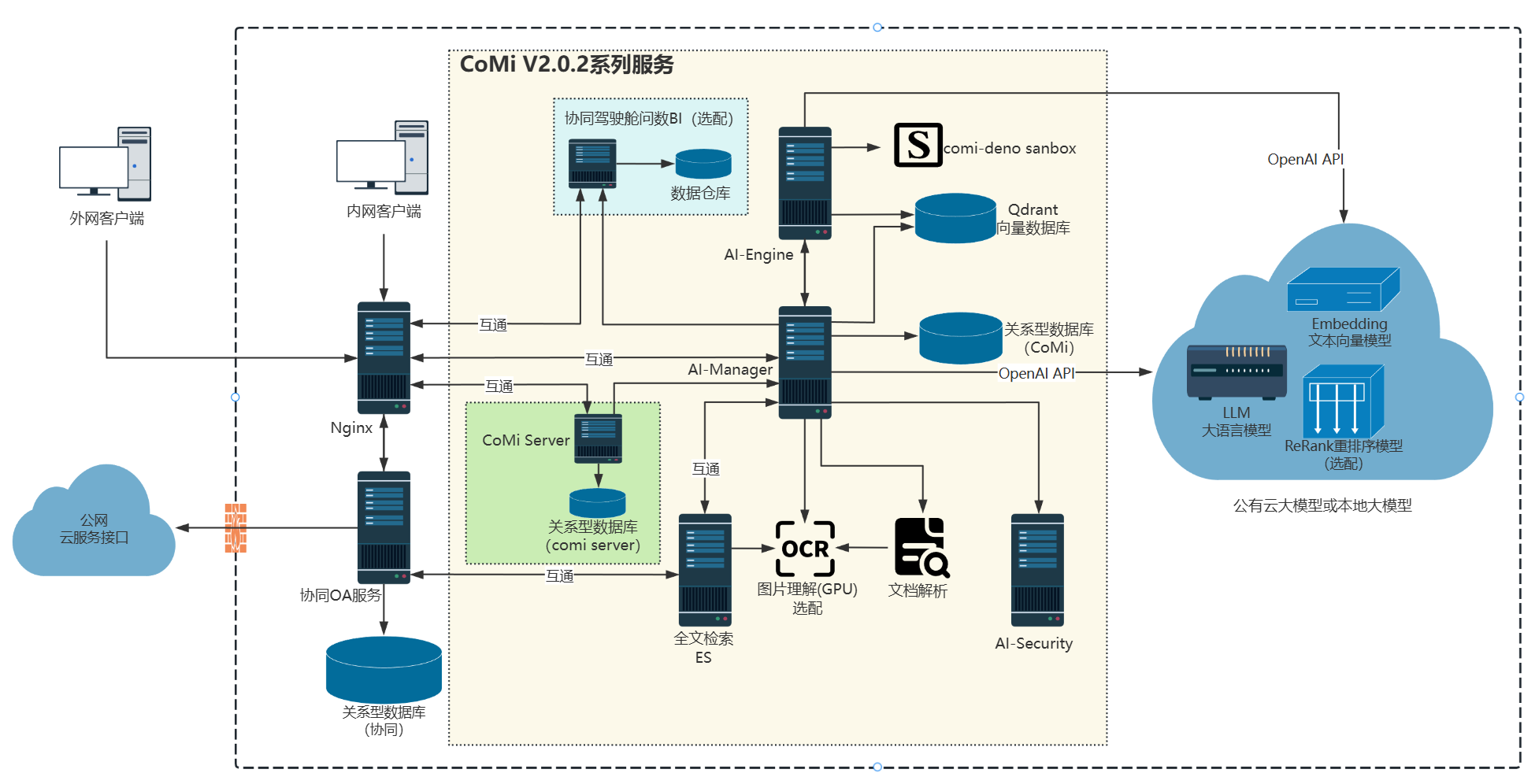

# 部署架构图

客户端、协同OA与CoMi V2.0.2版本相关服务的部署关系如下图所示(图中每个节点对应一个服务,多个服务可以根据情况部署在一台服务器):

注意:

协同服务访问公网云服务接口说明:安全助理智能体(无此需求可忽略)会定期采集外部热门威胁情报,需要添加网络白名单的地址:

(1) 致远官方漏洞库查询接口:https://service.seeyon.com

(2) 国际漏洞库CVE查询工具 :https://www.cve.org ; https://cveawg.mitre.org 详细说明见《CoMi用户操作手册》

CoMi系列服务可部署在一台服务器,当前仅支持单机模式,暂无高可用方案

CoMi V2.0.2相关服务说明及配置建议:

- 协同OA服务/协同数据库:必须,老客户已部署协同无需增配,全新客户参考协同部署手册准备资源

- LLM大语言模型:必须,需客户准备,具体要求见后续大模型章节

- Embedding文本向量模型:必须,需客户准备,具体要求见后续大模型章节

- ReRank重排序模型:非必须,需客户准备,具体要求见后续大模型章节

- Nginx服务:必须,建议资源不低于

2C/4G/100G,老客户已部署无需增配,可独立部署、也可部署至协同OA服务器或部署至CoMi服务器,CoMi需要依赖Nginx才能实现与协同OA保持同域和安全通信 - AI-Engine服务:必须,端口8000,建议资源不低于

4C/8G/200G,推荐与其它CoMi服务部署至一台服务器 - AI-Manager服务:必须,端口8181,建议资源不低于

4C/16G/200G,依赖关系数据库存储数据(支持范围见CoMi数据库),针对当前服务新建一个库,推荐与其它CoMi服务部署至一台服务器 - AI-Security服务:非必须,端口9000,建议资源不低于

4C/8G/200G,仅使用安全助理智能体可选装,推荐与其它CoMi服务部署至一台服务器 - CoMi Server服务,必须,端口8081,建议资源不低于

4C/8G/200G,依赖关系数据库存储数据(支持范围见CoMi数据库),针对当前服务新建一个库,CoMi前端UI和CoMi APP均需要此服务,推荐与其它CoMi服务部署至一台服务器。 - AI-DocumentParse文件解析服务,必须,端口9880,CoMi V2.0.2版本新增文件解析服务,需要同AI-Manager服务部署在同一服务器,供AI-Manager访问调用。

- comi-deno 沙箱为必部署组件,占用端口 8877,该组件在 CoMi V2.0.2 版本新增,核心用于对工作流代码节点的运行进行安全隔离与权限管控,仅允许执行预设白名单内的方法,规避非合规代码执行带来的安全风险,保障系统运行安全;该组件需要与 AI-Security 服务部署在同一服务器,供 AI-Engine 访问调用。注:CoMi Docker 部署模式不涉及沙箱服务(容器本身就是一种安全隔离)。

- Qdrant向量库:必须,端口6333、6334,建议资源不低于

4C/8G/200G,推荐与其它CoMi服务部署至一台服务器。 - CoMi数据库:必须,支持MySQL、SQLServer、Oracle、达梦、金仓,数据库有版本要求(详见后续章节),建议资源不低于

4C/8G/200G,(满足版本要求的前提下)可复用协同数据库资源,也可与其它CoMi服务部署至一台服务器。 - 协同驾驶舱BI含数据库:非必须,端口8058、5432,智能问数场景需要部署,建议500在线用户资源不低于

16C/32G/300G,更高在线根据实际情况扩大配置。如老客户已部署协同驾驶舱BI,则需要参考智能问数部署手册检查是否需要升级BI程序版本。 V8云原生产品线(A9C)不涉及此服务。 - 全文检索服务:必须,端口和建议资源见全文检索部署手册,建议单独部署。 V8云原生产品线(A9C)不涉及额外部署此服务。

- OCR解析服务:非必须,端口12841,CoMi V2.0.2版本新增OCR解析服务,基于飞浆paddleocr PP-OCRv5开源模型引擎运行,需要GPU环境,建议单独带GPU服务器下维护,操作系统仅支持Ubuntu22.04 X86架构。无此服务的影响:向量知识库无法解析图片、PDF扫描件。

- 在单台服务器资源足够大的前提下,推荐CoMi系列服务(Ai-Engine、AI-Manager、AI-Security、APP Server、AI-DocumentParse、deno沙箱、Qdrant、驾驶舱BI)部署在同一台服务器利于维护。

协同OA和CoMi服务的对应关系:

- 协同OA和CoMi服务是一一对应关系,不允许出现两套OA连接同一个CoMi服务的情况

- 如使用协同智能搜索知识问答功能,协同会通过ES将文档推送给COMi服务进行向量化,如果两套OA都推送会导致CoMi异常

- CoMi部署时需要配置协同OA的Nginx访问地址,这个地址是唯一的,故也必须做到一一对应。

# 服务器准备

根据上一章节多个服务可以集中部署在一台服务器原则,以下是生产环境推荐服务器规划(项目上可根据实际情况自行调整):

| 服务器 | 数量 | 配置要求 | 备注 |

|---|---|---|---|

| Nginx服务器 | 1台 | CPU>=2C/内存>=4G/数据盘100G | 单独部署灵活性更高,但不要求绝对单独部署,推荐Linux/信创系统 |

| CoMi服务器 | 1台 | 不含问数CPU>=16C/内存>=32G/数据盘>=500G 含智能问数CPU>=32C/内存>=64G/数据盘>=1000G | 包含CoMi系列服务,注意服务器硬件资源是CoMi各服务资源的总和,推荐Linux/信创系统,无需GPU |

| 全文检索 | - | 阶梯配置参考全文检索部署手册 | 如需使用协同知识问答,则需要全文检索服务 |

| OCR解析服务 | 1台 | CPU>=4C/内存>=32G/数据盘500G/需要GPU(推荐NVIDIA RTX 4090单张),操作系统要求Ubuntu22.04 X86架构 | 非必须,该服务对硬件和系统环境要求特殊,无此服务仅影响无法解析图片和扫描件 |

| LLM大语言模型 | - | - | 必备,客户提供 |

| Embedding文本向量模型 | - | - | 必备,客户提供 |

| ReRank重排序模型 | - | - | 非必须,客户提供 |

| 协同主服务器 | - | 见协同部署手册 | |

| 协同数据库服务器 | - | 见协同部署手册 |

# 大模型作用和推荐

依赖LLM大语言模型(必须),需客户准备:

- 支持公有云和本地化模型,需要提供OpenAI接口,同时支持Function Calling功能(如不支持,涉及调用协同和第三方的智能体应用均无法使用)。

- 作用:CoMi使用语言模型进行意图识别、调用决策、分析总结,LLM模型是超级核心。

- 公有云推荐阿里百炼平台 (opens new window)qwen-plus、DeepSeek官网 (opens new window)非思考模式的模型(deepseek-chat)、火山引擎 (opens new window)豆包旗舰模型、以及华为模型平台、硅基流动等一众公有云模型服务商的模型(优先选择旗舰级模型)。

- 本地化部署模型推荐近期较新的开源MOE模型(30B参数起步),所需算力由低到高推荐:Qwen3-30B-A3B-Instruct-2507、Qwen3-Next-80B-A3B-Instruct、Qwen3-235B-A22B-Instruct-2507、DeepSeek-V3.2。

- 不要使用DeepSeek带思考过程的模型(如 DeepSeek-R1 和 deepseek-reasoner ),该模型没有Function calling能力,内部【模型能力测试】 (opens new window)多个功能不可用;并且带思考过程的模型每次请求都很慢,执行稍微复杂的Agent任务就会出现请求超时或响应极其缓慢影响用户体验的问题,使用思考模型要谨慎!

- 生产级本地化模型服务推荐使用高效的vllm推理引擎,Tokens上下文建议输入32K以上,输出8K。

- 本地化模型依赖很高的服务器算力,并且其算力资源由 模型参数大小、量化精度(FP16/FP8/INT4)、激活策略(Moe/Dense)、上下文大小和并发数 等综合因素决定,建议咨询专业模型部署厂商评估和落地。

依赖Embedding文本向量模型(必须),需客户准备:

- 支持公有云和本地化模型,需要提供OpenAI接口,Embedding模型别名词嵌入模型

- 作用:解决无法检索企业私域知识的关键模型,将企业文本数据转化为向量,实现语义搜索,让CoMi能够实现自然语言检索企业知识的能力

- 模型需支持不低于8192 Tokens(8K上下文长度)的输入,向量维度默认1024

- 公有云推荐 硅基流动AI平台bge-m3 (opens new window)、华为云大模型平台beg-m3 (opens new window)(以后可较低成本切本地bge-m3模型)

- 本地化部署Embedding模型,标准产品推荐bge-m3

依赖ReRank重排序模型(非必须),需客户准备:

- 支持公有云和本地化模型,需要提供OpenAI接口

- 如需向量检索+全文检索多路召回能力提升检索质量,则必须使用ReRank模型

- 公有云推荐 硅基流动AI平台bge-reranker-v2-m3 (opens new window)、华为云大模型平台bge-reranker-v2-m3 (opens new window)(以后可较低成本切本地bge-reranker-v2-m3模型)

- 本地化部署ReRank模型推荐bge-reranker-v2-m3(支持8k token上下文)

大模型扩展资料:

- 如需了解什么是OpenAI接口,接口应该如何测试可参考《CoMi模型配置操作手册 (opens new window)》中的测试示例。

- 本地化模型涉及较大成本投入和专业部署技能,不在CoMi部署和方案支持范围内。如客户需要代采,公司战略合作与生态产品团队与模型专业供应商有建联,推出了<致远COMI一体机解决方案-本地大模型>方案,可与政务营销推进部liuxuan联系询价。

- 如客户具备自主部署维护模型能力,想了解最低算力和相关模型下载地址,可参考《CoMi知识库-硬件成本预估 (opens new window)》在线文档和视频。

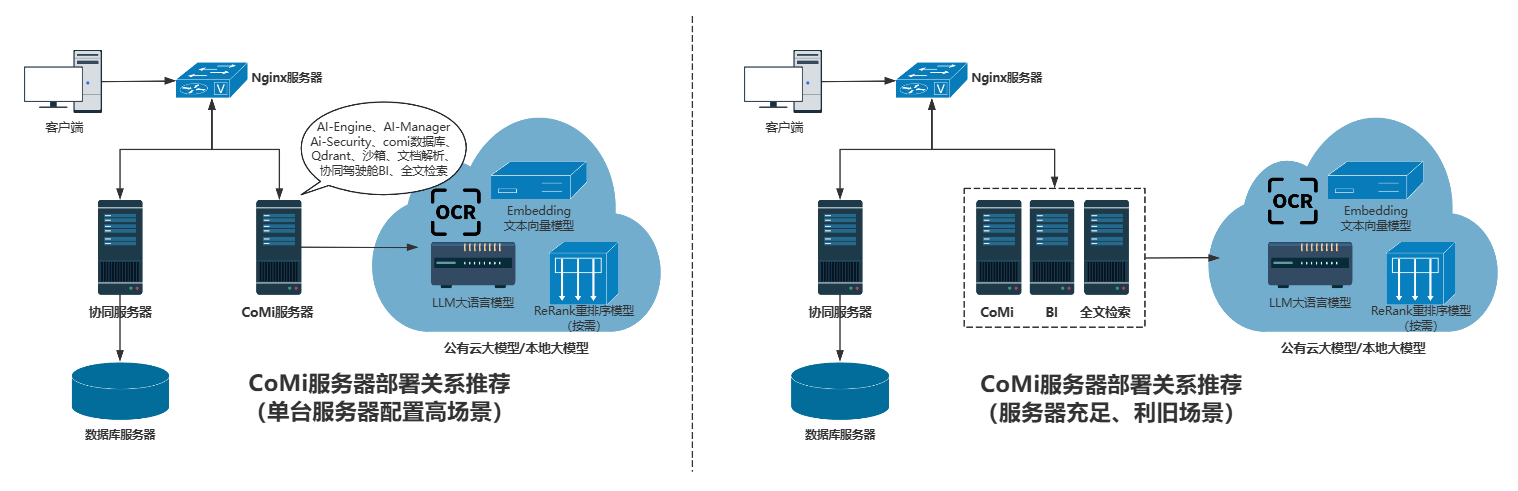

# CoMi服务器部署规划

CoMi相关服务器资源规划: CoMi可以在一台,也可以多个服务分离部署,无论哪种方式需要确保服务器资源足够(避免引发生产系统性能故障)

- 如单台服务器资源足够大,可以考虑CoMi多个相关服务部署在一起

- 如服务器充足,或此前已经部署过全文检索、BI,可以复用现有服务器资源,只针对CoMi其它服务准备一台服务器

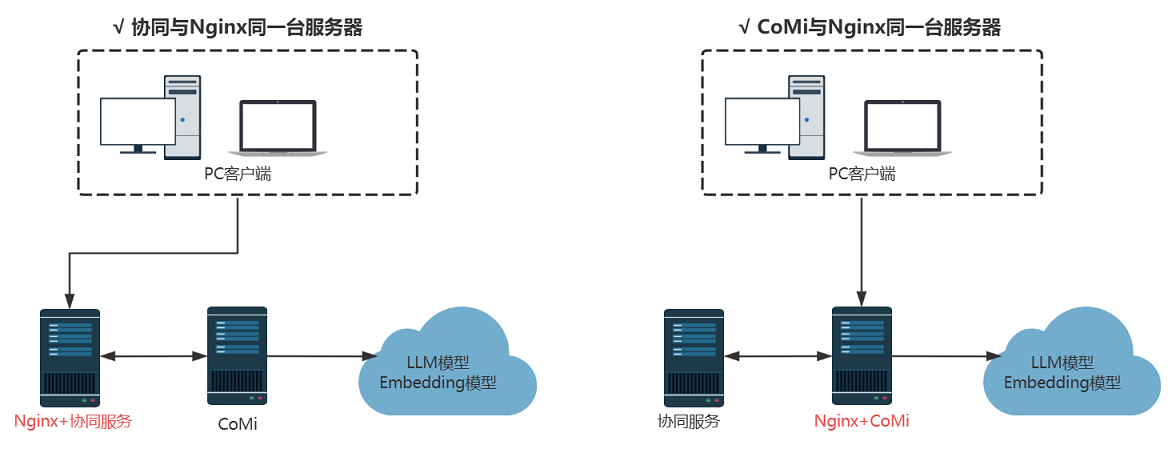

Nginx服务器规划: (服务器数量有限情况下)协同可与Nginx同一台服务器,或者CoMi与Nginx同一台服务器,确保服务器总资源是否满足需求即可:

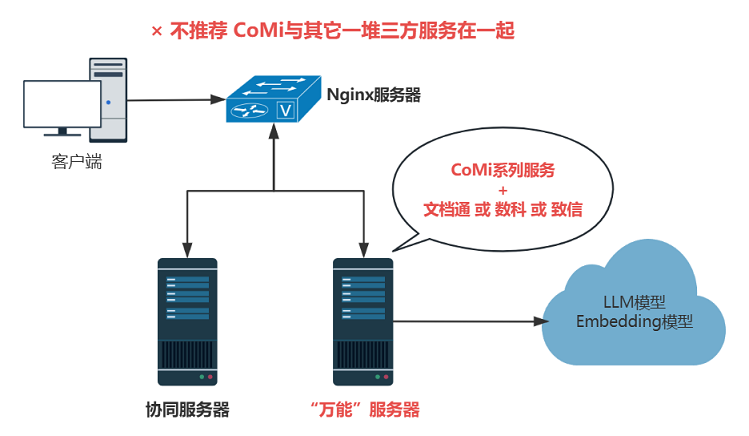

(服务器数量有限情况下)生产环境不推荐CoMi系列服务与文档通、数科、致信等服务部署在一起,避免端口冲突、资源争抢等问题:

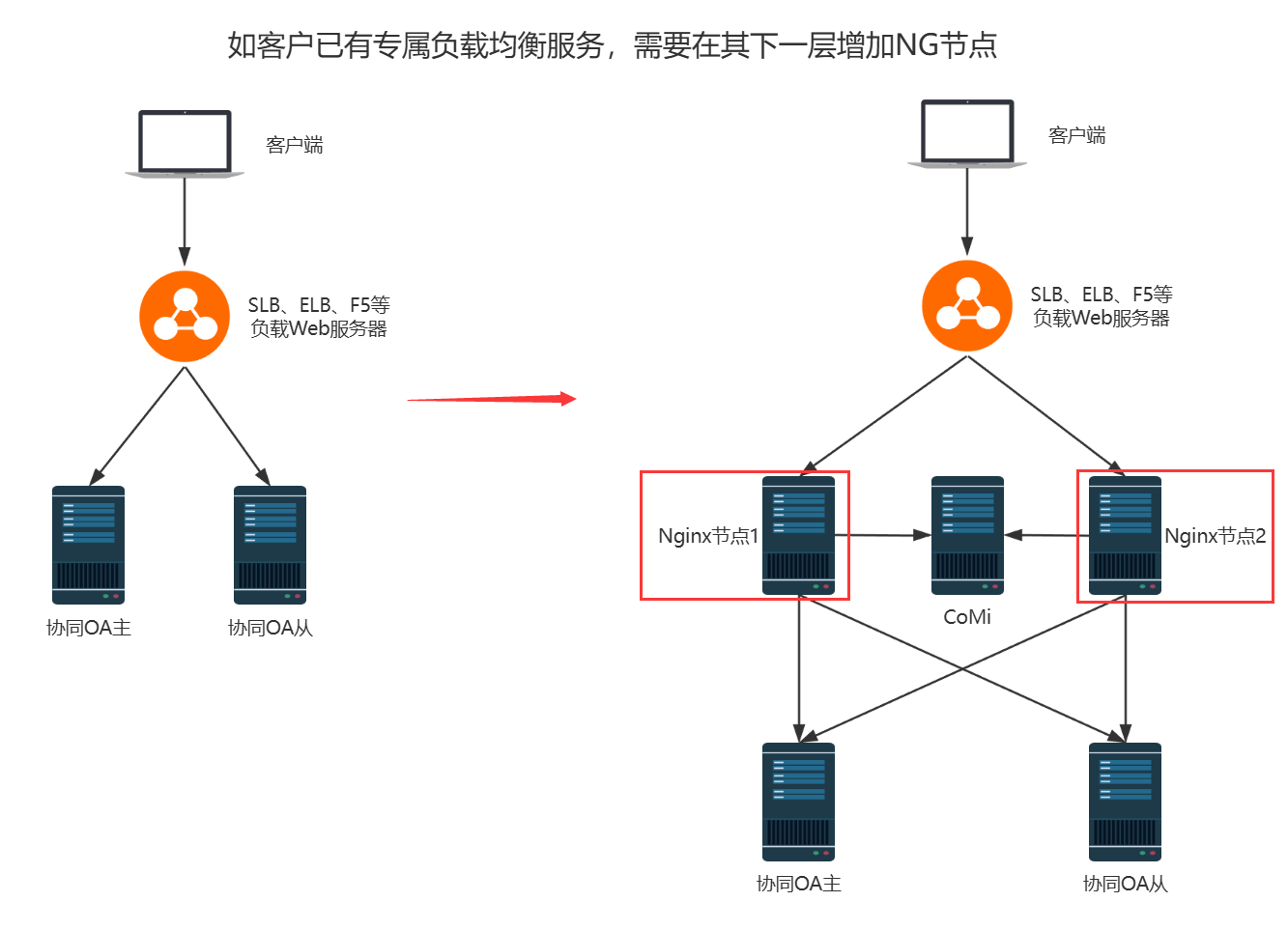

(客户已经在使用自己的SLB、ELB或F5等Web服务)这种场景下依然需要追加2台Nginx服务,将2台Nginx放在客户专属Web服务后面、协同OA前面,示意图如下:

在部署过程中,很多地方需要配置Nginx内网地址,如果是SLB + 2台Nginx服务器模式,所有涉及NG地址的配置均指向Nginx节点1即可。

# 安装包准备

从商务公布的安装程序地址下载(文档中心-文档库-营销中心-营销体系销售管理知识库-产品下载地址-提交给区域产品下载地址xxx.xls),产品线对应AI:

# 适配协同版本

CoMi 2.0(含V2.0.1、V2.0.2)标准产品随V5产品线协同V10.0SP1版本匹配发布,即标准支持V5产品线V10.0SP1版本,同时也提供了极少量V5产品线协同低版本适配。

CoMi 2.0对V5产品线和V8云原生产品线(A9C)对应版本适配列表详见《协同版本边界feishu知识库 (opens new window)》,如表格中有打补丁需求,需要严格按表格中的说明操作。

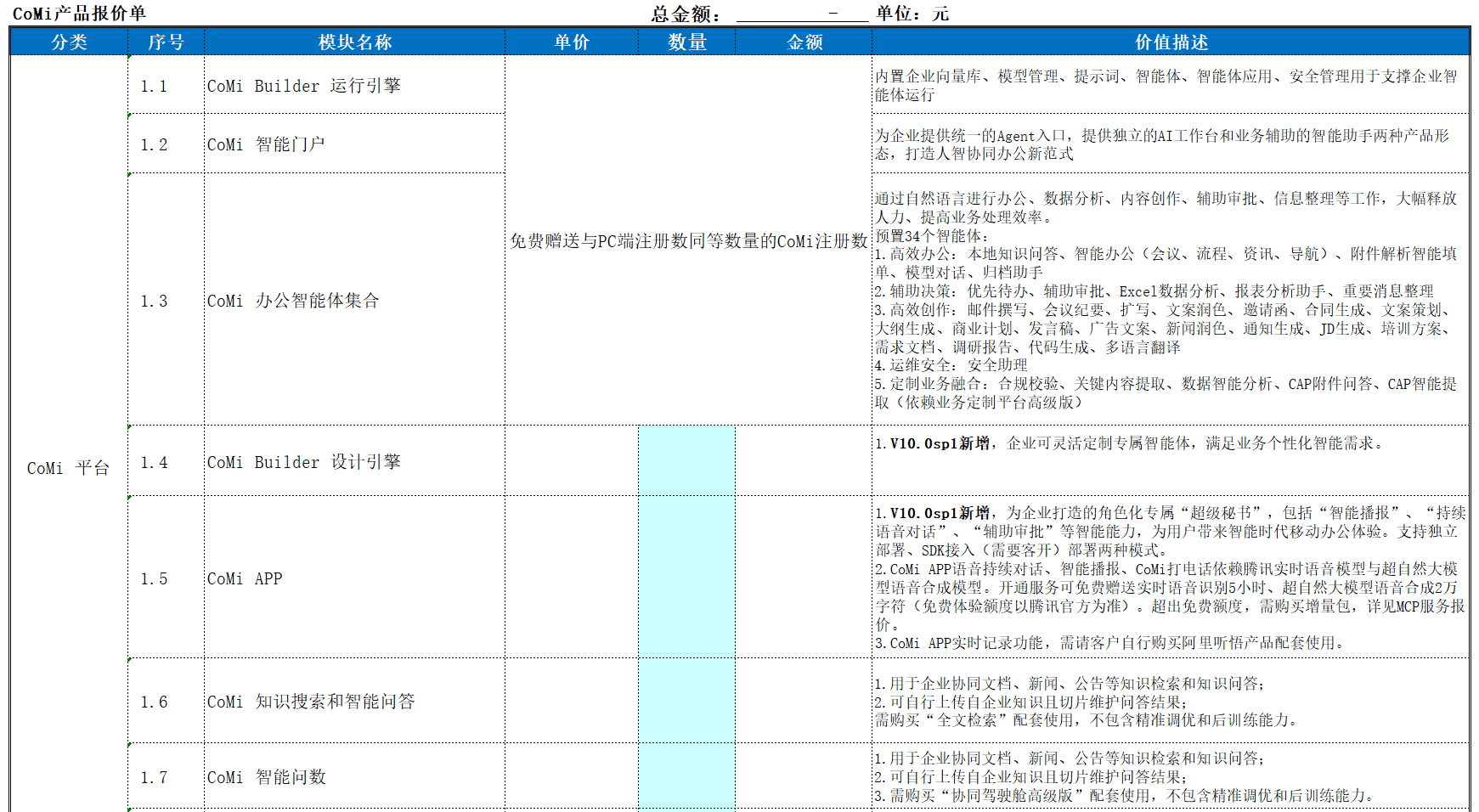

# 商务插件和功能对照

CoMi V2.0系列版本需要在协同OA中增加对应插件,V5产品线详细插件清单和报价以商务公告《V10.0sp1产品上市通知》为准(协同低版本使用CoMi2.0政策详询商务):

[CoMi知识库飞书在线文档] (opens new window) 提供了V5产品线相关插件模块和浏览器兼容性说明。

用户可能不会使用全部CoMi功能,以下针对CoMi关键功能列举V5产品线所需插件和所需服务:

| 功能 | V5产品线插件 | A9C产品线插件 | 所需服务 |

|---|---|---|---|

| ★CoMi基础底座-包含设计器 | CoMi设计引擎 (需要CoMi超级入口插件) | CoMi智能助手 | 协同服务、LLM模型、Embedding模型、Nginx、AI-Engine、AI-Manager、Qdrant、数据库 |

| 协同知识搜索和智能问答 | 增加 CoMi知识搜索和智能问答 插件、全文检索插件 | CoMi智能助手 | 全文检索服务 |

| 智能问数 | 增加 协同驾驶舱高级版-运行平台 和 CoMi智能问数 插件、以及申请永洪BI报表引擎License | - | 协同驾驶舱高级版服务 |

| CoMi移动APP | CoMi APP模块(需要CoMi超级入口插件) | CoMi智能助手 | CoMi Server |

| CAP4接入CoMI Agent组件 | 增加 CAP+Agent 插件、应用定制平台高级版 | - | 无 |

注:

- CoMi基础底座是必须组件,所有增值功能都在CoMi基础底座基础上增量运行。

- 如V5产品线无需设计器,只需要开箱即用CoMi智能体,则可以申请不含设计器的CoMi基础插件: CoMi运行引擎 、CoMi超级入口。

关于 V8云原生产品线(A9C) ,如需使用CoMi,需要申请CoMi智能助手 comiPlugin。

# 操作系统支持

CoMi V2.0系列(不含OCR图片解析)服务支持如下操作系统:

| 分类 | 支持情况 |

|---|---|

| 权限要求 | 需要以管理员(root)权限操作 |

| 支持操作系统 | CentOS 7、CentOS 8 RedHat 7、RedHat 8 openEuler 24.03-LTS Anolis 8.10 Ubuntu 22.04 LTS 麒麟V10 统信UOS V20 |

| 服务器类型 | x86、Arm |

OCR图片解析服务部署要求: 仅支持X86架构 + Ubuntu22.04 + GPU环境(推荐NVIDIA RTX 4090单张),整个环境包括驱动需要客户提前准备,OCR图片解析服务基于飞浆paddleocr PP-OCRv5开源模型引擎运行。

如无特殊要求,不建议使用Windows系统部署CoMi:没有部署工具、部署繁琐、易出错!

# 适配数据库版本范围

CoMi V2.0系列版本支持的数据库版本要求如下,不在版本范围的数据库不可用:

- mysql5.7、mysql8.0 (mysql都用utf8-mb4字符集)

- 达梦8.4

- 人大金仓(电科金仓)V8R6(Oracle兼容模式)

- postgreSQL 13.3

- sqlServer 2019

- oracle 19c(其它Oracle版本不支持)

数据库参数配置兼容要求与协同OA一致,故可以复用协同OA数据库服务(新建comi的数据库)。

(不涉及信创合规性)也推荐快速部署MySQL,实现comi单独数据库维护:

# CoMi系列服务部署方式

# 部署模式和资料

CoMi V2.0系列服务支持多种部署方式,项目上可根据用户情况选择合适的部署模式:

| 方案 | 部署方式 | 支持操作系统 | 部署说明 | 推荐指数 | 部署手册 |

|---|---|---|---|---|---|

| 方案1 | 向导式部署 | Linux、信创系统 | 自动安装CoMi基础服务,浏览器网页可视化启停+调整参数,简单易用 适合大部分环境,尤其信创项目 当前方案不支持自动部署如下服务:Nginx、全文检索、数据库,这些服务需要手工部署 | ★★★★★ | 手册链接 (opens new window) |

| 方案2 | Docker容器部署 | Linux、信创系统 | 自动安装docker和CoMi基础服务,包括MySQL数据库、智能问数、Nginx均可自动安装,适合快速搭建出效果,需要具备一定Linux维护经验 当前方案不支持集成信创数据库 当前方案不支持自动部署如下服务:全文检索,这个服务需要手工部署 | ★★★☆ | 手册链接 (opens new window) |

方案一部署视频学习路径: 协同云→赋能中心→致远学院→搜索 CoMi V2.0使用智能工具部署演示

方案二部署视频学习路径: 协同云→赋能中心→致远学院→搜索 CoMi V2.0使用Docker部署演示

其它独立服务部署手册如下:

| 编号 | 服务名 | 支持操作系统 | 部署说明 | 部署手册 |

|---|---|---|---|---|

| 1 | Nginx | Linux、信创系统 | Nginx部署手册参考 (opens new window) | |

| 2 | 全文检索 | Windows Server、Linux、信创系统 | 10.0SP1全新部署后无需打补丁 早期版本全文检索需要打补丁 | 全文检索10.0SP1部署手册参考 (opens new window) 全文检索老版本补丁更新手册 (opens new window) |

| 3 | 数据库 | Windows Server、Linux、信创系统 | 可复用协同数据库,但注意检查适配版本 | MySQL8部署手册参考 (opens new window) |

| 4 | 智能问数 | Windows Server、Linux、信创系统 | 向导式部署工具支持自动部署智能问数,只有无法使用向导式工具场景才需参考手册独立部署 | 协同驾驶舱V3.0独立部署手册 (opens new window) |

| 5 | OCR图片解析服务 | 仅支持Ubuntu22.04 | Docker + Container Toolkit下运行,依赖GPU,环境要求较高 | OCR图片理解模型Docker部署手册 (opens new window) |

# 部署方案示例

以下提供几种场景下服务部署方案示例:

场景一:V5产品线V10.0SP1信创新客户使用CoMi2.0全家桶(CoMi基础应用、智能问数、CoMi Server APP、协同知识检索)

场景一顺序部署方案:

- 申请以上相关全部插件,部署V10.0SP1产品,参考手册:协同主服务-信创维护手册 (opens new window)

- 部署Nginx代理协同OA,参考手册: Nginx部署手册参考 (opens new window)

- 使用工具部署CoMi基础应用、智能问数、CoMi Server APP ,参考手册: 智能工具部署手册 (opens new window)

- 参考上一步手册进行模型的配置和CoMi应用初始化

- 智能问数部署后需要进行初始化,参考手册:智能问数V3.0部署配置手册 (opens new window) (跳过部署,直接到初始化章节;注:客户如果是信创的话,可能需要达梦数据库)

- 部署全文检索V10.0SP1,参考手册:全文检索部署维护手册V10.SP1 (opens new window)

- 全文检索配置集成CoMi实现知识检索能力,参考手册:CoMi V2.0全文检索协同知识问答配置手册 (opens new window)

注:场景一没有推荐CoMi使用Docker一体化部署,是因为一体化部署使用了MySQL和Postgresql数据库,客户信创可能过不了。

场景二:V5产品线非信创老客户(如V9.0SP1版本)使用CoMi2.0全家桶(CoMi基础应用、智能问数、CoMi Server APP、协同知识检索)

场景二顺序部署方案:

- 首先,先判断客户的OA版本是否支持CoMi 2.0,是否支持全家桶功能,并不是所有老版本功能都支持!参考手册:《协同版本边界feishu知识库 (opens new window)》

- 判断老版本的BuildID是否对的上,如果对不上,则需要小小升级协同OA老版本到支持的BuildID上,如V9.0SP1 B240731微小升级到V9.0SP1 B250518

- 申请以上相关全部插件

- 部署Nginx代理协同OA(如客户已有NG,则利旧),参考手册: Nginx部署手册参考 (opens new window)

- 使用工具部署CoMi基础应用、智能问数、CoMi Server APP ,参考手册: 智能工具部署手册 (opens new window) 。或者使用Docker容器部署也非常快,参考手册:CoMi V2.0 Docker一体化部署手册 (opens new window)

- 参考上一步手册进行模型的配置和CoMi应用初始化

- 智能问数部署后需要进行初始化,参考手册:智能问数V3.0部署配置手册 (opens new window) (跳过部署,直接到初始化章节;注:客户如果此前已经部署了协同驾驶舱高级版,也要求更新到V3.0版本)

- 部署最新的V10.0SP1全文检索服务,如低版本已经产生了索引数据,需要重建索引,具体详见 参考手册:CoMi V2.0全文检索协同知识问答配置手册 (opens new window)

- 全文检索配置集成CoMi实现知识检索能力,参考手册:CoMi V2.0全文检索协同知识问答配置手册 (opens new window)

# 扩展:V8云原生产品线(A9C)所需资源汇总

V8云原生产品线(A9C)是另一套协同产品,基于微服务云原生技术开发维护,其所需服务和V5有一定差别,本章节针对V8云原生产品线(A9C)所需资源做一个汇总说明。

| 维度 | |

|---|---|

| V8产品线依赖CoMi组件清单 | AI-Manager、AI-Engine、AI-Security、Qdrant、数据库(版本匹配可复用OA库),CoMi V2.0.2开始还需部署CoMi Server、沙箱、文档解析服务,按需部署OCR图片解析服务(需GPU)。 |

| V8产品线集成CoMi模型清单 | LLM语言模型(必须)、Embedding模型(必须)、ReRank模型(按需),模型由客户提供 |

| V8产品线CoMi服务所需资源 | CPU>=16C/内存>=32G/数据盘>=500G,独立服务器维护,操作系统见上文,不支持K8S运行 |

| V8产品线部署方式 | 支持向导式部署和Docker容器化部署两种,二选一,手册同上文,按需选择依赖组件部署 |

| V8产品线集成CoMi所需插件 | 插件名称及标识:CoMi智能助手 comiPlugin |

| V8产品线部署CoMi关键步骤 | 1、参考CoMi手册部署V8产品线所需CoMi组件 2、参考CoMi手册增加V8 Nginx配置 3、(确保当前V8版本支持CoMi)更新V8产品线加密授权 4、到V8产品线后台初始化模型、应用、以及做后续操作,参考《A9领航版AI办公助手手册 (opens new window)》 |

快速跳转