# CoMi V1.1环境准备指导手册

北京致远互联软件股份有限公司

2025年9月

# 前言

本手册对致远新一代智能体产品家族CoMi V1.1版本服务器环境准备相关事宜进行说明,如对本手册中相关内容存在疑问,请与致远互联的客户服务人员联系。

comi 1.1是目前comi最新版本。

# 名词解释

- CoMi:指致远新一代智能体产品家族,是致远围绕AI大模型打造的智能应用产品,需要服务器资源独立部署运行。

- AI大模型:指基于海量数据训练,拥有超大参数规模的人工智能深度学习模型,具有理解与生成、知识推理等能力,可支持多种智能应用场景。

- LLM大语言模型:模型细分领域之一,通常“大模型”都特指LLM大语言模型,LLM模型针对自然语言处理任务、以文本为主要输入输出的大型深度学习模型,擅长对话、写作、翻译、总结等语言相关任务。

- Embedding模型:将文本等信息映射到稠密向量空间/向量数据库的模型,使语义相似的内容距离更近,便于向量检索、语义搜索、相似度计算等应用,常用于RAG检索增强生成场景。

- 检索增强生成(RAG):Retrieval-Augmented Generation的缩写,将外部知识库(如向量数据库)检索到的相关内容与大模型生成结合起来的技术,可提升模型的知识广度与回答准确度。该方案常用于解决模型无法回复企业私域知识的问题。

- 向量数据库:专门存储与检索高维向量数据的数据库系统,支持高效相似度搜索,常与Embedding模型配合使用,用于语义检索、推荐系统、RAG等场景。

- ReRank模型:排序优化模型,用于在候选结果基础上根据上下文和语义相关性重新排序,提升搜索、推荐等任务的结果精确度,常用于多路召回/混合检索场景。

- OpenAI规范:由OpenAI提出的接口与交互规范,包括模型调用格式、消息结构、参数约定等,大部分智能应用(包含CoMi)均基于OpenAI规范与大模型交互。

- Function Call(函数调用):大模型在推理过程中引导Agent调用外部函数或API以执行特定任务的机制,能够将语言生成与外部业务逻辑结合,实现动态查询与处理。解决了大模型无法获取实时数据的问题,大部分智能应用(包含CoMi)调用第三方及MCP均采用大模型的Function calling能力。

- Agent智能体 :指基于大模型能力构建的具备任务执行和多轮交互能力的应用组件。Agent是运行在用户与大模型之间的中间件应用(

[用户] → [Agent] → [模型]),Agent可根据目标拆解任务、调用外部工具(Function Call)、检索知识库、处理实时数据,并结合上下文生成结果。它能够在无人干预的情况下完成较为复杂的流程,常用于智能客服、自动化运维、数据分析等场景。CoMi即是由若干Agent组成的智能体产品家族。 - 模型Tokens :大模型处理文本的最小单位,人类输入的文字最终会转换成大模型认识的Tokens,输入和输出的长度都以Token计数,影响上下文长度与调用成本。不同模型对Token的换算方式不同,如DeepSeek官方解释文字和token的换算比例为:1 个英文字符 ≈ 0.3 个 token;1 个中文字符 ≈ 0.6 个 token。

- 模型上下文长度:大模型在一次处理过程中可接收的最大Token数量,“输入上下文”对应模型提示词最大录入长度;“输出上下文”对应模型最大回复长度。

- 提示词(Prompt) :指用户输入给模型的指令或问题,用于引导模型生成答案。通过AI对话框发送的问题就是提示词。

- 协同OA服务:指致远协同办公软件核心服务,包含组织数据、协同、工作流等核心功能。

- 开放平台:致远技术开放平台网站,站点包含协同应用技术、运维等手册和解决方案,地址 https://open.seeyoncloud.com (opens new window)。

# CoMi环境准备

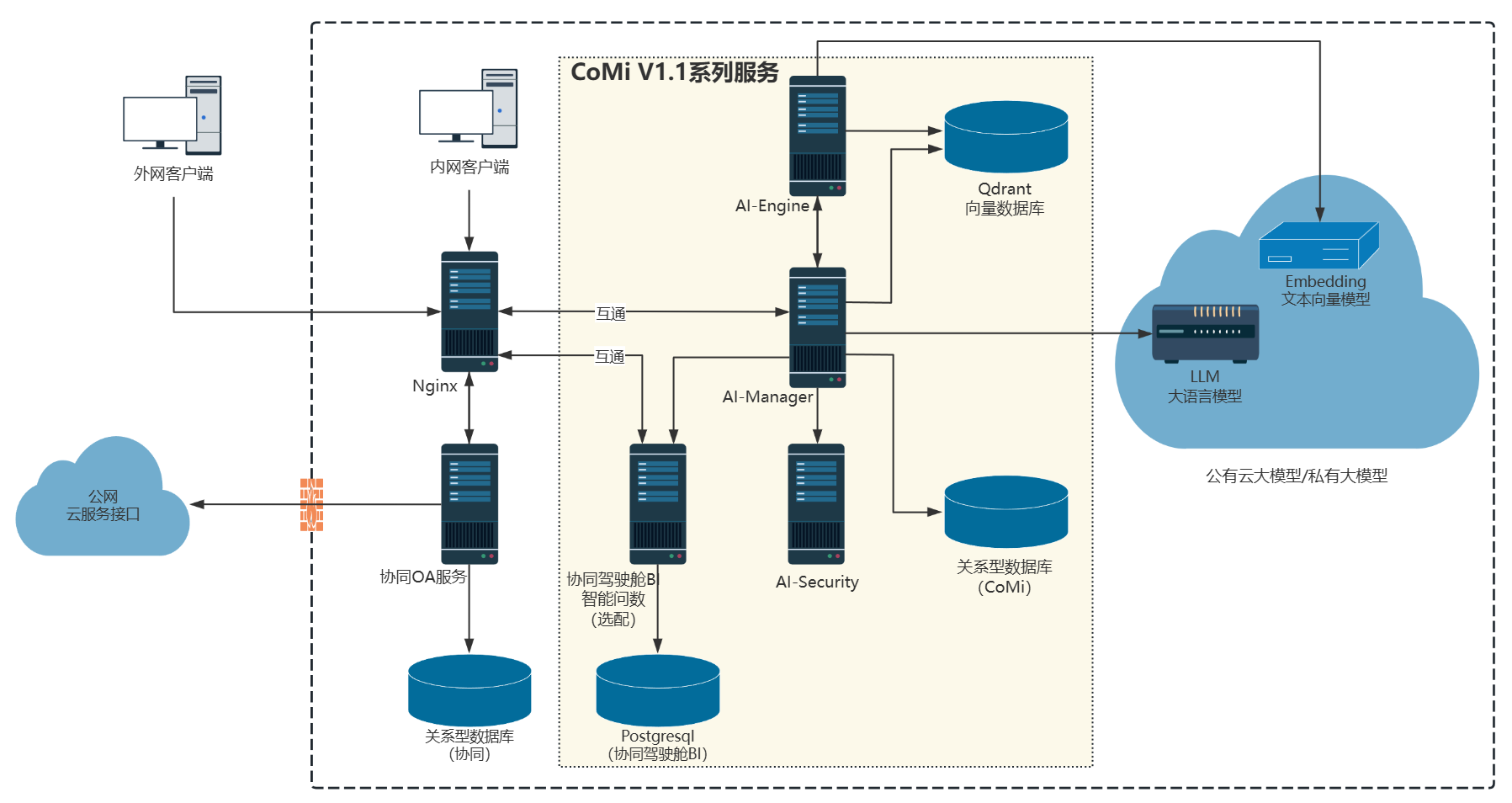

# 部署架构图

客户端、协同OA与CoMi V1.1版本相关服务的部署关系如下图所示(图中每个节点对应一个服务,多个服务可以根据情况部署在一台服务器):

注意:

协同服务访问公网云服务接口说明:安全助理智能体(无此需求可忽略)会定期采集外部热门威胁情报,需要添加网络白名单的地址:

(1) 致远官方漏洞库查询接口:https://service.seeyon.com

(2) 国际漏洞库CVE查询工具 :https://www.cve.org ; https://cveawg.mitre.org 详细说明见《CoMi用户操作手册》

CoMi系列服务可部署在一台服务器,当前仅支持单机模式,暂无高可用方案

相关服务说及配置要求:

- 协同OA服务/协同数据库:必须,老客户已部署协同无需增配,全新客户参考协同部署手册准备资源

- LLM大语言模型:必须,需客户准备,具体要求见后续环境准备章节

- Embedding文本向量模型:必须,需客户准备,具体要求见后续环境准备章节

- Nginx服务:必须,建议资源不低于

2C/4G/100G,老客户已部署无需增配,可独立部署、也可部署至协同OA服务器或部署至CoMi服务器,CoMi需要依赖Nginx才能实现与协同OA保持同域和安全通信 - AI-Engine服务:必须,端口8000,建议资源不低于

4C/8G/200G,推荐与其它CoMi服务部署至一台服务器器 - AI-Manager服务:必须,端口8181,建议资源不低于

4C/16G/200G,推荐与其它CoMi服务部署至一台服务器器 - AI-Security服务:非必须,端口9000,建议资源不低于

4C/8G/200G,仅使用安全助理智能体可选装,推荐与其它CoMi服务部署至一台服务器 - Qdrant向量库:必须,端口6333、6334,建议资源不低于

4C/8G/200G,推荐与其它CoMi服务部署至一台服务器器 - CoMi数据库:必须,支持MySQL、SQLServer、Oracle、达梦、金仓,数据库有版本要求(详见后续章节),建议资源不低于

4C/8G/200G,(满足版本要求的前提下)可复用协同数据库资源,也可与其它CoMi服务部署至一台服务器 - 协同驾驶舱BI含数据库:非必须,端口8058、5432,智能问数场景需要部署,建议500在线用户资源不低于

16C/32G/300G,更高在线根据实际情况扩大配置。如老客户已部署协同驾驶舱BI,则需要参考智能问数部署手册检查是否需要升级BI程序版本。 - 在单台服务器资源足够大的前提下,推荐CoMi系列服务(Ai-Engine、AI-Manager、AI-Security、Qdrant、驾驶舱BI)部署在同一台服务器利于维护

# 服务器准备

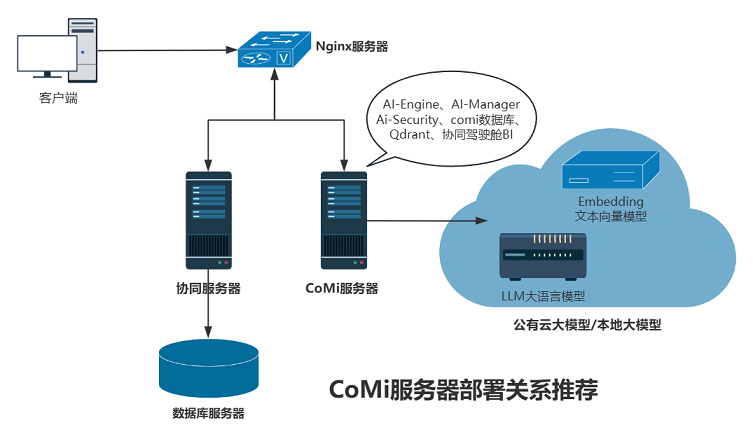

根据上一章节多个服务可以集中部署在一台服务器原则,以下是生产环境推荐服务器规划(项目上可根据实际情况自行调整):

| 服务器 | 数量 | 配置要求 | 备注 |

|---|---|---|---|

| Nginx服务器 | 1台 | CPU>=2C/内存>=4G/数据盘100G | 单独部署灵活性更高,但不要求绝对单独部署,推荐Linux/信创系统 |

| CoMi服务器 | 1台 | 不含问数CPU>=16C/内存>=32G/数据盘>=500G 含智能问数CPU>=32C/内存>=64G/数据盘>=1000G | 包含CoMi系列服务,注意服务器硬件资源是CoMi各服务资源的总和,POC演示环境配置可减半,推荐Linux/信创系统 |

| LLM大语言模型 | - | - | 必备,客户提供,支持公有云和本地化模型,要求遵守OpenAI接口规范,同时支持FunctionCalling功能(如不支持,涉及调用协同和第三方的智能体应用均无法使用),Tokens上下文建议64K以上 |

| Embedding文本向量模型 | - | - | 必备,客户提供,支持公有云和本地化模型,要求遵守OpenAI接口规范,且Embedding模型需支持不低于8192 Tokens(8K上下文长度)的输入,向量维度默认1024 |

| 协同主服务器 | - | 见协同部署手册 | |

| 协同数据库服务器 | - | 见协同部署手册 |

大模型作用和推荐:

- LLM大语言模型:作用:CoMi使用语言模型进行意图识别、调用决策、分析总结,LLM模型是超级核心;推荐:通义千问(qwen3、qwen3-next、公有云qwen-plus等)和深度求索DeepSeek-V3,CoMi V1.1版本暂不推荐DeepSeek-R1(function call兼容尚存在问题),本地化部署推荐qwen2.5 72b,(资源有限的情况下)建议本地化qwen3-32b-awq起步。不同模型、不同参数、不同量化精度、不同模型引擎所需资源均不同,模型所需硬件显卡资源建议咨询模型部署厂商。

- Embedding文本向量模型:作用:解决无法检索企业私域知识的关键模型,将企业文本数据转化为向量,实现语义搜索,让CoMi能够实现自然语言检索企业知识的能力;推荐:本地化部署BAAI/bge-m3,或使用公有云阿里百炼平台的text-embedding-v3、text-embedding-v4等。不同模型、不同参数、不同量化精度、不同模型引擎所需资源均不同,模型所需硬件显卡资源建议咨询模型部署厂商。

- 本地化模型涉及较大成本投入和专业部署技能,不在CoMi部署和方案支持范围内。如客户需要代采,公司战略合作与生态产品团队与模型专业供应商有建联,推出了<致远COMI一体机解决方案-本地大模型>方案,可与生态团队zhanglei联系询价。

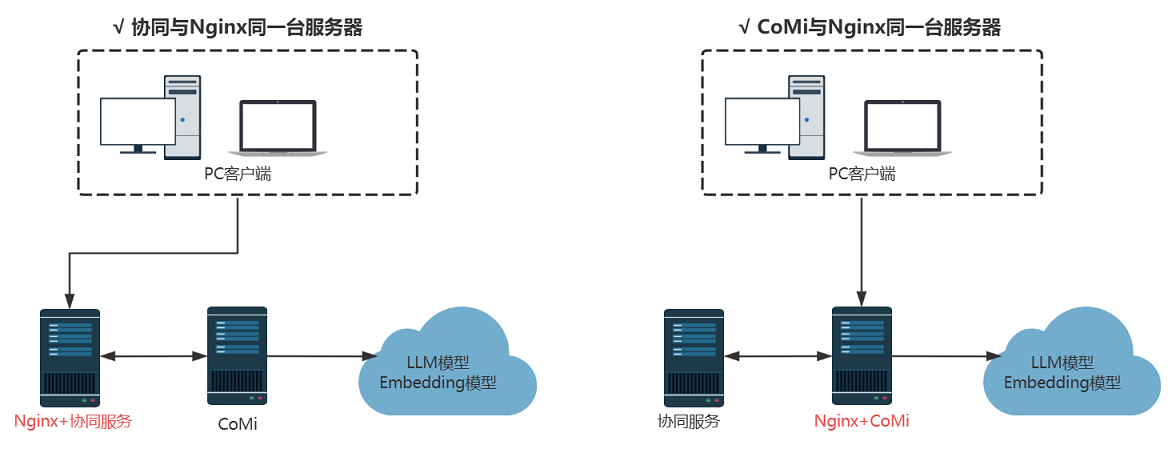

(服务器数量有限情况下)协同可与Nginx同一台服务器,或者CoMi与Nginx同一台服务器,确保服务器总资源是否满足需求即可:

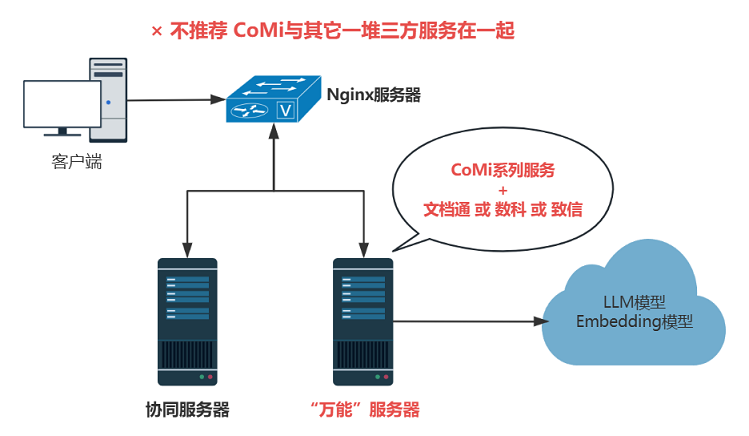

(服务器数量有限情况下)生产环境不推荐CoMi系列服务与文档通、数科、致信等服务部署在一起,避免端口冲突、资源争抢等问题:

# OpenAI模型测试示例

为了验证客户提供的大模型是否支持OpenAI接口,可以从客户侧获取大模型的CURL测试命令(OpenAI接口格式),在CoMi服务器执行CURL命令测试大模型是否返回正确数据以及返回时间以评估模型响应性能。

LLM大语言模型测试示例

{path}/v1/chat/completions 请求是OpenAI推出的与语言模型对话的标准接口,执行成功会获得模型的对话信息。

由客户提供客户的语言模型地址、model模型名称、API_KEY(如有),替换如下命令对应参数在CoMi服务器执行测试:

curl -X POST http://192.168.94.130:11434/v1/chat/completions \

-H "Authorization: Bearer $DASHSCOPE_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "qwen-plus",

"messages": [

{

"role": "user",

"content": "你是谁?"

}

]

}'

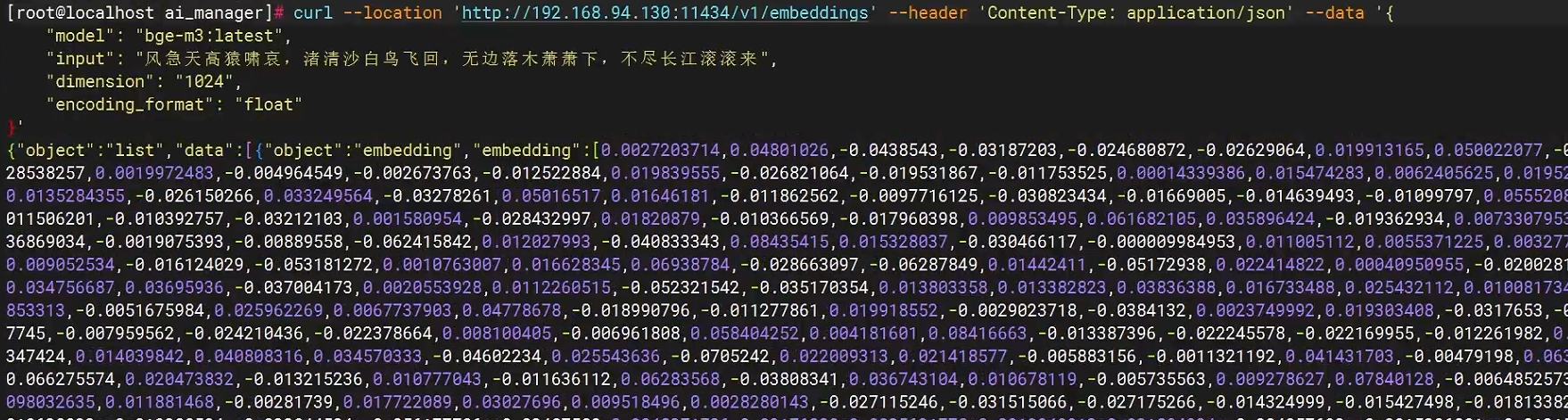

Embedding文本向量模型测试示例

{path}/v1/embeddings 请求是OpenAI推出的与Embedding模型对话的标准接口,执行成功会获得模型的向量化结果。

由客户提供客户的Embedding模型地址、model模型名称、API_KEY(如有),替换如下命令对应参数在CoMi服务器执行测试:

curl --location 'http://192.168.94.130:11434/v1/embeddings' \

--header "Authorization: Bearer $DASHSCOPE_API_KEY" \

--header 'Content-Type: application/json' \

--data '{

"model": "bge-m3:latest",

"input": "风急天高猿啸哀,渚清沙白鸟飞回,无边落木萧萧下,不尽长江滚滚来",

"dimension": "1024",

"encoding_format": "float"

}'

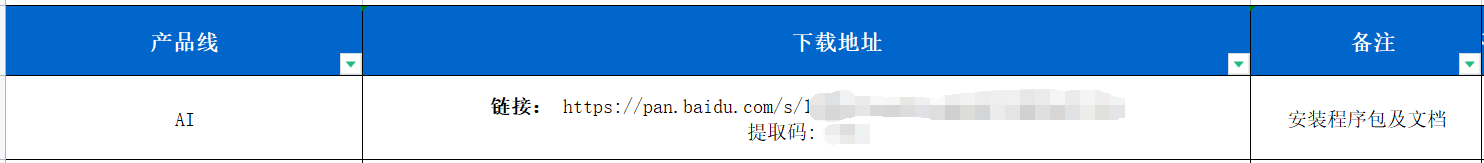

# 安装包准备

从商务公布的安装程序地址下载(文档中心-文档库-营销中心-营销体系销售管理知识库-产品下载地址-提交给区域产品下载地址xxx.xls),产品线对应AI:

# 适配协同版本

CoMi V1.1适配以下协同OA版本:

- V5产品线 V10.0 B250710及以上,协同侧无需打补丁

- V5产品线 V9.0SP1 B250715及以上,协同侧无需打补丁

comi 1.1对V5产品线V9.0、V8.2、V8.1、V8.0等早期版本适配情况详见CoMi安装包里的协同OA低版本补丁,协同侧需按要求打补丁:

# 商务插件准备

CoMi V1.1涉及如下插件:

- 必备:协同OA加密狗插件 - CoMi平台(CoMi Builder运行引擎、CoMi智能门户) 和 CoMi智能体套件(CoMi办公智能集合体),致远商务侧下单申请,计价规则见商务报价

- 按需:如需智能问数,涉及申请“协同驾驶舱高级版-运行平台”协同OA加密狗插件、“CoMi智能问数”协同OA加密狗插件、以及报表引擎License,致远商务侧下单申请

# 操作系统支持

CoMi V1.1系列服务支持如下操作系统:

如无特殊要求不建议使用Windows系统部署CoMi:部署繁琐、易出错

| 分类 | 支持情况 |

|---|---|

| 权限要求 | 需要以管理员(root)权限操作 |

| 支持操作系统 | Windows Server 2016以上 CentOS 7、CentOS 8 RedHat 7、RedHat 8 openEuler 24.03-LTS Anolis 8.10 Ubuntu 22.04 LTS 麒麟V10 统信UOS V20 |

| 服务器类型 | x86、Arm |

# 适配数据库版本范围

CoMi V1.1支持的数据库版本要求如下,不在版本范围的数据库不可用:

- mysql5.7、mysql8.0

- 达梦8.4

- 人大金仓(电科金仓)V8R6(Oracle兼容模式)

- postgreSQL 13.3

- sqlServer 2019

- oracle 19c(其它Oracle版本不支持)

数据库参数配置兼容要求与协同OA一致,故可以复用协同OA数据库服务(新建comi的数据库)。(不涉及信创合规性)也推荐快速部署MySQL,实现comi单独数据库维护:

# CoMi系列服务部署方式

CoMi V1.1系列服务支持多种部署方式,项目上可根据用户情况选择合适的部署模式:

| 编号 | 部署方式 | 支持操作系统 | 部署说明 | 推荐指数 | 部署手册 | 部署视频 |

|---|---|---|---|---|---|---|

| 1 | Docker容器部署 | Linux、信创系统 | 自动安装docker和CoMi基础服务,包括智能问数、Nginx均可自动安装,适合快速搭建出效果 | ★★★★★ | 链接 (opens new window) | 无 |

| 2 | 工具可视化部署 | Linux、信创系统 | 工具安装在Win客户端,通过SSH远程连接CoMi服务器安装及启停管理,但Qdrant、智能问数、Nginx需要脱离工具手动安装,适合生产环境 | ★★★★★ | 链接 (opens new window) | 有 |

| 3 | Linux手动部署 | Linux、信创系统 | Linux系统上通过命令安装部署维护CoMi系列服务,手册不含智能问数,适合生产环境,手工部署利于熟悉CoMi服务间关系和排错 | ★★★★ | 链接 (opens new window) | 有 |

| 4 | Windows手动部署 | Windows Server | 部署步骤相对繁琐,依赖运行库,较易出错,手册不含智能问数 | ★★ | 链接 (opens new window) | 有 |

| 除Docker容器部署外,其余部署方式需要按需单独部署智能问数 | 智能问数链接 (opens new window) | 无 | ||||

| 除Docker容器部署外,其余部署方式需要按需单独部署Nginx | Nginx部署参考 (opens new window) | 有 |

# CoMi系列服务部署建议

首次部署CoMI建议:

- 1、先看一遍视频,从头到尾看一遍,了解部署所需环境、资源准备要求、部署顺序、部署细节

- 2、拿着在线手册,结合着视频一步步实操部署,基本都能通过

- 3、熟练后,CoMi核心组件手动部署(不含问数)一般在1~2小时

- 4、熟练后,使用Docker容器部署(含问数)一般在0.5小时

Docker容器一体化部署CoMi V1.1手册:

- 手册 https://open.seeyoncloud.com/#/faq/vuepressFile/v1/share?url=Z2ptZkplPjM3Ojg=

- 视频 通过协同云-赋能中心-致远学院学习 https://pro.coolcollege.cn/#/course/enterpriseCourse?courseId=2225990648882925568

工具可视化部署CoMi V1.1手册Linux:

- 手册 https://open.seeyoncloud.com/#/faq/vuepressFile/v1/share?url=Z2ptZkplPjM3ODg=

- 视频 通过协同云-赋能中心-致远学院学习 https://pro.coolcollege.cn/#/course/enterpriseCourse?courseId=2208610067639570432

CoMi V1.1手动安装部署手册Linux:

- 手册 https://open.seeyoncloud.com/#/faq/vuepressFile/v1/share?url=Z2ptZkplPjM3ODM=

- 视频 通过协同云-赋能中心-致远学院学习 https://pro.coolcollege.cn/#/course/enterpriseCourse?courseId=2208608757603241984

CoMi V1.1手动安装部署手册Windows:

- 手册 https://open.seeyoncloud.com/#/faq/vuepressFile/v1/share?url=Z2ptZkplPjM3ODQ=

- 视频 通过协同云-赋能中心-致远学院学习 https://pro.coolcollege.cn/#/course/enterpriseCourse?courseId=2224062316473880576

【腾讯文档】CoMi1.1版本智能问数部署和使用

- 手册 https://docs.qq.com/doc/DYUFBVFJBU2pUbGxa

- 视频 暂无

Nginx部署参考手册:

- Nginx安装部署参考手册 https://open.seeyoncloud.com/#/faq/vuepressFile/v1/share?url=Z2ptZkplPjI6Njk=

- Nginx安装视频 通过协同云-赋能中心-致远学院 https://pro.coolcollege.cn/#/course/enterpriseCourse?courseId=2165639290556649472

- Nginx反向代理配置协同HTTP https://open.seeyoncloud.com/#/faq/vuepressFile/v1/share?url=Z2ptZkplPjIzMzQ=

- Nginx反向代理配置协同视频 通过协同云-赋能中心-致远学院 https://pro.coolcollege.cn/#/course/enterpriseCourse?courseId=2165638674157539328

快速跳转