# 模型对话部署配置手册

本手册适用于部署配置“模型对话”应用场景

2025年3月

本手册详细描述了如何部署维护模型对话应用,在实施部署模型对话应用前,请确保完整地阅读了本手册,以便对模型对话的环境要求、部署配置模式有一个全局性认知。

# 修订记录

| 修订内容 | 修订时间 |

|---|---|

| 结构调整,确保操作步骤有序化 | 2025-3-14 |

| 新增Windows Server部署支持 | 2025-3-5 |

| 细化部分文字的说明,以便运维理解 | 2025-3-5 |

| 调整依赖OA版本中的说明 | 2025-3-4 |

# 在线化资料支持

手册存在不定期更新,为了方便您获取最新资料,本手册在致远开放平台也放置了一份,建议您收藏以下地址,并尽量使用在线手册以获得最新的部署信息:https://open.seeyoncloud.com/#/faq/vuepressFile/v1/share?url=Z2ptZkplPjM0Nzo= (opens new window)

# 环境准备

# 依赖OA版本

“模型对话”适配V8.0及以上版本,每个版本要求对应BuildID,不匹配则需要升级到对应BuildID再打“模型对话”插件补丁。适配情况如下:

补丁包下载链接: https://pan.baidu.com/s/1UfyGDfMV4BJYuinuKPxuig?pwd=yws3 提取码: yws3

| 版本 | 支持的BuildID(其余ID不支持) | 插件部署方式 |

|---|---|---|

| V9.0SP1 | B250320.132210.CTP182303072 | 推荐升级到该版本不需要打补丁 |

| V8.2SP1 | B240705.143211.CTP163800112 | 补丁 |

| V8.2 | B230831.000206.CTP96061989 | 补丁 |

| V8.1SP2 | B230116.170509.CTP43833697 或 B230811.153410.CTP90602533 | 补丁 |

| V8.1SP1 | B220830.182158.CTP23069290 | 补丁 |

| V8.1 | B220318.183029.CTP990705 | 补丁 |

| V8.0SP2LTS | B220630.110814.CTP8828883_LTS | 补丁 |

| V8.0SP2 | B210518.144014.CTP3994_202105181438 | 补丁 |

| V8.0SP1 | B201101.2955.CTP212388 | 补丁 |

| V8.0 | B200613.2565.CTP203851 | 补丁 |

| G6 V8.0 SP1 | B210305.2140.CTP73733 | 补丁 |

| G6 V8.0 | B200721.1817.CTP66469 | 补丁 |

| G6-N5.0 SP1 | B210305.2140.CTP73733 | 补丁 |

| G6-N5.0 | B200721.1817.CTP66469 | 补丁 |

# 依赖组件

如需使用模型对话插件时,涉及如下三个相关组件,各自组件的作用及提供方如下:

| 编号 | 组件名 | 组件作用 | 部署模式 | 提供方 |

|---|---|---|---|---|

| 1 | 协同OA服务-模型对话插件 | 提供应用访问入口和交互 | 购买“模型对话”插件+补丁包 | 致远 |

| 2 | 模型管理服务 | 独立的微服务,用于协同与大模型的桥接,必须全新部署 | 参考本手册安装部署章节 | 致远 |

| 3 | 三方大语言模型 | 依赖DeepSeek之类大语言模型,用于回复问题 | 客户自行准备 | 客户 |

注意:

1、三方大语言模型组件不在致远的服务范围,需要客户选型并实施落地,公有云或私有均支持。

2、如需使用移动端M3进行模型对话,需要确保客户的M3 APP(iOS和Android)版本大于等于4.7.5。

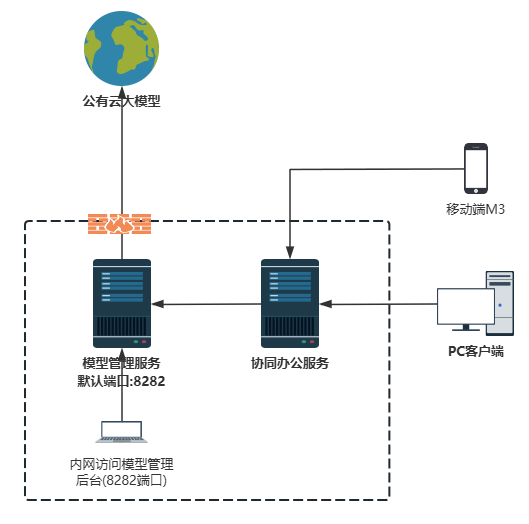

一个正常的模型对话运行流程如下图所示:

# 服务器资源要求

| 编号 | 组件名 | 部署要求 |

|---|---|---|

| 1 | 协同OA服务-模型对话插件 | 无需调整,保持现有协同OA服务配置 |

| 2 | 模型管理服务 | 操作系统:Windows Server、Linux、信创系统 CPU: >= 2核 内存: >= 4GB 硬盘: >= 50GB JDK: OpenJDK 17.0.12(程序默认自带JDK,若信创环境无法运行需联系信创系统厂商提供,版本必须JDK17) |

| 3 | 三方大模型 | 支持公有云大模型(无服务器资源要求),也支持私有模型(以大模型专业厂商方案为准) |

注意:

- 信创系统当前验证了麒麟ARM

# 大模型适配范围

产品支持接入满足openai规范的大语言模型(公有或私有均支持),其他情况下有一定的适配工作量,具体支持模型如下:

- DeepSeek(V3、R1)

- 通义千问(qwen2.5、qwen-plus)

- ChatGpt(4o)

注意:

- 三方大模型必须遵守OpenAI标准接口规范,不能增加或调整请求参数,不能增加或调整返回值格式,非标模型需要自行定制开发。

- 私有模型大小推荐:deepseek-r1:32b及以上、qwen2.5:32b及以上

- 大模型中一些较低参数的蒸馏版(如1.5b、7b)仅适用学习或轻量级应用;产品支持接入低参数的蒸馏版,但可能出现回复不准确问题

- 私有模型硬件配置和实施建设咨询华为、腾讯等三方专业厂商

# 网络架构图

# 接入公有云大模型

需要确保协同办公服务能连接到“模型管理服务”(默认端口8282),建议协同办公服务与模型管理服务部署在同一局域网,以获得最优的网络通信体验。

需要一台客户端电脑能访问模型管理服务来做后台大模型参数配置。

建议模型管理服务不要暴露到外网,以确保信息安全。

如客户采用公有云大模型,需要确保“模型管理服务”能连接到公有云大模型:

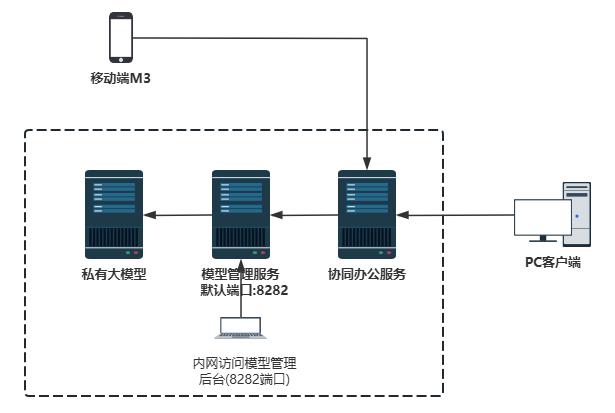

# 接入私有大模型

需要确保协同办公服务能连接到“模型管理服务”(默认端口8282),建议协同办公服务与模型管理服务部署在同一局域网,以获得最优的网络通信体验。

需要一台客户端电脑能访问模型管理服务来做后台大模型参数配置。

建议模型管理服务不要暴露到外网,以确保信息安全。

如客户采用私有大模型,需要确保“模型管理服务”能连接到私有大模型,建议服务保持在同一局域网,以获得最优的网络通信体验:

# 部署步骤

# 一、准备和测试大模型

客户提前准备产品适配范围内的大模型( 必须兼容OpenAI规范 ),并提供一些必要的信息供产品后续配置使用,主要包含:

1、Base URL:模型的api接口地址,并开通网络策略确保产品能访问到模型地址

2、model模型名称:务必是准确的model,如deepseek-r1:8b、deepseek-r1:32b

3、API Key:授权信息,公有云都会有这个;私有化有的没有API Key,以私有部署厂商回复为准

无论是公有云还是私有大模型,都可以通过CURL命令来对模型进行调试,通过调试参数就能获得Base URL、API Key以及模型名称,也能确定模型是否可用,如模型不可用则先解决CURL不可用问题再进行后续部署!

# 公有云大模型测试示例

以阿里云百炼平台公有云大模型为例,获取模型CURL和模型重要参数方法为:

1、先访问百炼平台官网 https://bailian.console.aliyun.com/ 使用阿里系的帐号登录官网

2、通过模型广场找到需要接入的大模型:

3、访问大模型的API调用示例,参考下图指引就能获得有效的base url、APIKey、model模型名称,并且在Linux测试:

Linux下测试效果,看到返回值就表示测试通过:

Windows可以用如下转换后的格式发送请求,将$DASHSCOPE_API_KEY替换为有效的API KEY,将model值deepseek-r1替换为有效的模型名称测试:

curl -X POST https://dashscope.aliyuncs.com/compatible-mode/v1/chat/completions -H "Authorization: Bearer $DASHSCOPE_API_KEY" -H "Content-Type: application/json" -d "{\"model\": \"deepseek-r1\",\"messages\": [{\"role\": \"user\",\"content\": \"9.9和9.11谁大\"}]}"

填入准确的参数后,通过Windows的cmd命令同样获得了结果:

综上,通过curl测试确定当前环境能连通大模型并获得答案,同时根据curl获得了百炼大模型的几个重要参数,在后续配置时即可直接使用:

1、Base URL:对应https://dashscope.aliyuncs.com/compatible-mode(取curl地址/v1/chat/前面的路径)

2、model模型名称:对应curl中"model"的值,如本示例的deepseek-v3

3、API Key:取百炼官网个人的API KEY,取本示例Authorization: Bearer后面这段内容

扩展资料:

其它公有云大模型自行参考模型官网的手册

DeepSeek多平台接入方式-百度 阿里 抖音 硅基流动 https://www.bilibili.com/video/BV1PLN9ecEws

阿里云错误码地址(排查问题用)https://help.aliyun.com/zh/model-studio/developer-reference/error-code

# 私有大模型测试示例

私有大模型需要联系部署模型的技术人员提供curl地址,也可以使用如下转换后的编码,再填入客户真实的私有大模型信息测试:

# 不带API KEY的私有大模型测试命令(注意替换/v1/chat前面的地址,和model的值为客户真实的信息)

curl -X POST http://10.1.131.174:11434/v1/chat/completions -H "Content-Type: application/json" -d "{\"model\": \"deepseek-r1:32b\",\"messages\": [{\"role\": \"user\",\"content\": \"写一首诗\"}]}"

测试一个不带API KEY的私有模型效果如下:

综上,通过curl测试确定当前环境能连通私有大模型并获得答案,同时根据curl获得了私有大模型的几个重要参数,在后续配置时即可直接使用:

1、Base URL:对应http://10.xx.xxx.xxx:1xxx4(取curl地址/v1/chat/前面的路径)

2、model模型名称:对应curl中"model"的值,如本示例的deepseek-r1:32b蒸馏模型

3、API Key:本例不涉及,后续配置时也不用录入

如果私有模型curl带有API KEY ,参考如下代码示例,则我们也能得到私有模型的几个重要参数:

1、Base URL:对应https://10.1.131.174:11434(取curl地址/v1/chat/前面的路径)

2、model模型名称:对应curl中"model"的值,如本示例的deepseek-r1:32b

3、API Key:对应ks-12121(取本示例Authorization: Bearer后面这段内容)

# 带API KEY的私有大模型测试命令

curl -X POST http://10.1.131.174:11434/v1/chat/completions -H "Authorization: Bearer ks-12121" -H "Content-Type: application/json" -d "{\"model\": \"deepseek-r1:32b\",\"messages\": [{\"role\": \"user\",\"content\": \"写一首诗\"}]}"

总结:在进行后续部署之前,务必先确保大模型已经准备到位,并且通过curl能测通,能根据curl获取base url、model、api-key这几个重要的参数!

# 二、部署模型管理服务

# Linux服务器部署步骤

以下适用于Linux、信创系统部署模型管理服务。

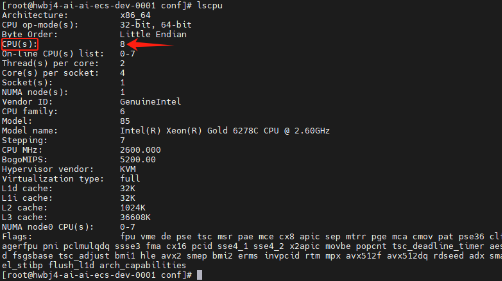

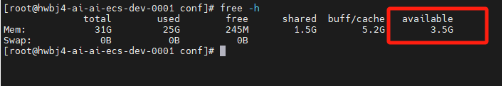

# Linux检查配置

- 使用命令 lscpu 检查 CPU 核数

- 使用命令 free -h 检查内存大小。

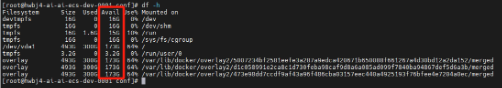

- 使用命令 df -h 检查硬盘空间。

# Linux获取并解压部署包

从公布的下载地址获取模型管理服务的部署包 ai-manager-llm.zip

阿里云盘: https://pan.seeyon.com/disk/s/k3ZMhvJcepx?pwd=692374

百度网盘:https://pan.baidu.com/s/1H81LLH_PzJXXfXmiGdExrA?pwd=bwgr

将 ai-manager-llm.zip 文件上传到目标服务器,并解压到指定目录(比如 /data/Seeyon/,不要放到ApacheJetspeed及其子目录下)。

mkdir -p /data/Seeyon

unzip ai-manager-llm.zip -d /data/Seeyon/

# Linux修改配置文件(必须)

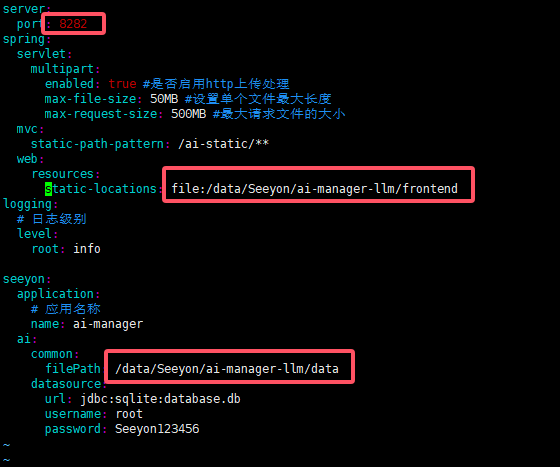

在解压后的目录(/data/Seeyon/ai-manager-llm)中找到 application.yaml 文件,并根据实际情况进行配置

cd /data/Seeyon/ai-manager-llm

vim application.yaml

server.port:无需修改,当前服务监听端口,默认8282,需要确保协同OA服务和配置模型参数的客户端能访问到此端口

spring.web.resources.static-locations:必须修改,前端静态文件的存储路径,需要指向解压后的ai-manager-llm/frontend(如参考本手册案例解压到/data/Seeyon目录,则填写的值格式必须是file:/data/Seeyon/ai-manager-llm/frontend)

seeyon.ai.common.filePath:必须修改,文件存储路径,需要指向解压后的ai-manager-llm/data(如参考本手册案例解压到/data/Seeyon目录,则填写的值格式必须是/data/Seeyon/ai-manager-llm/data)

# Linux启动服务

进入解压后的模型管理服务目录,执行 startup.sh 脚本以启动模型管理服务。

cd /data/Seeyon/ai-manager-llm

./startup.sh

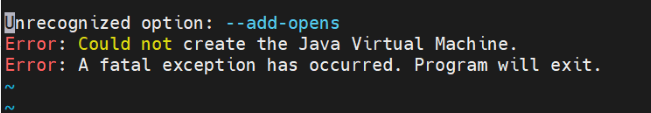

如果是信创环境,可能会因为JDK问题无法启动:

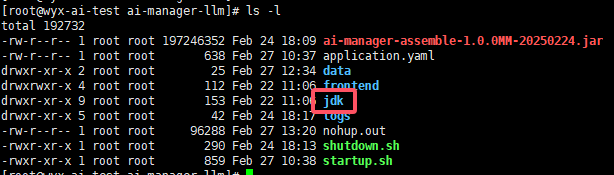

如遇信创环境无法启动,请联系信创操作系统厂商获取对应芯片架构的openjdk(jdk版本>=17),获取后重命名为jdk目录,并且替换ai-manager-llm目录下的jdk再进行服务启动,如图:

# Linux停止服务

如果需要停止服务,可以进入安装目录,执行 shutdown.sh 脚本以停止模型管理(AI-Manager) 服务。

cd /path/to/ai-manager-llm

./shutdown.sh

# Windows服务器部署步骤

以下适用于Windows Server服务器部署模型管理服务。

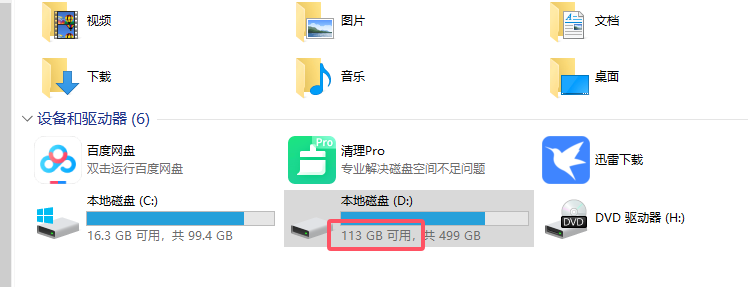

# Win检查配置

打开任务管理器,检查服务器CPU、内存资源是否满足需求

确认磁盘空间剩余空间满足要求

# Win获取和解压部署包

从公布的下载地址获取模型管理服务的部署包 ai-manager-llm.zip

阿里云盘: https://pan.seeyon.com/disk/s/k3ZMhvJcepx?pwd=692374

百度网盘:https://pan.baidu.com/s/1H81LLH_PzJXXfXmiGdExrA?pwd=bwgr

将ai-manager-llm.zip 件上传到目标服务器,并解压到指定目录(比如 d:\Seeyon,不要放到ApacheJetspeed及其子目录下)。

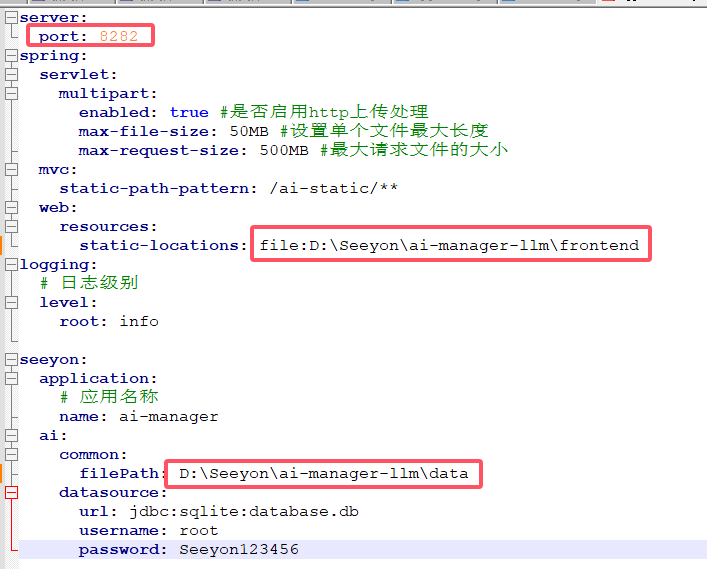

# Win修改配置文件(必须)

注意: Windows环境下修改配置文件不要用记事本编辑,会导致文件编码变化导致程序无法正常读取,可以使用专门的文本编辑工具

在解压后的目录(d:\Seeyon\ai-manager-llm)中找到 application.yaml 文件,并根据实际情况进行配置

server.port:无需修改,当前服务监听端口,默认8282,需要确保协同OA服务和配置模型参数的客户端能访问到此端口

spring.web.resources.static-locations:必须修改,前端静态文件的存储路径,需要指向解压后的ai-manager-llm/frontend(如参考本手册案例解压到D:\Seeyon目录,则填写的值格式必须是file:D:\Seeyon\ai-manager-llm\frontend)

seeyon.ai.common.filePath:必须修改,文件存储路径,需要指向解压后的ai-manager-llm/data(如参考本手册案例解压到D:\Seeyon目录,则填写的值格式必须是D:\Seeyon\ai-manager-llm\data)

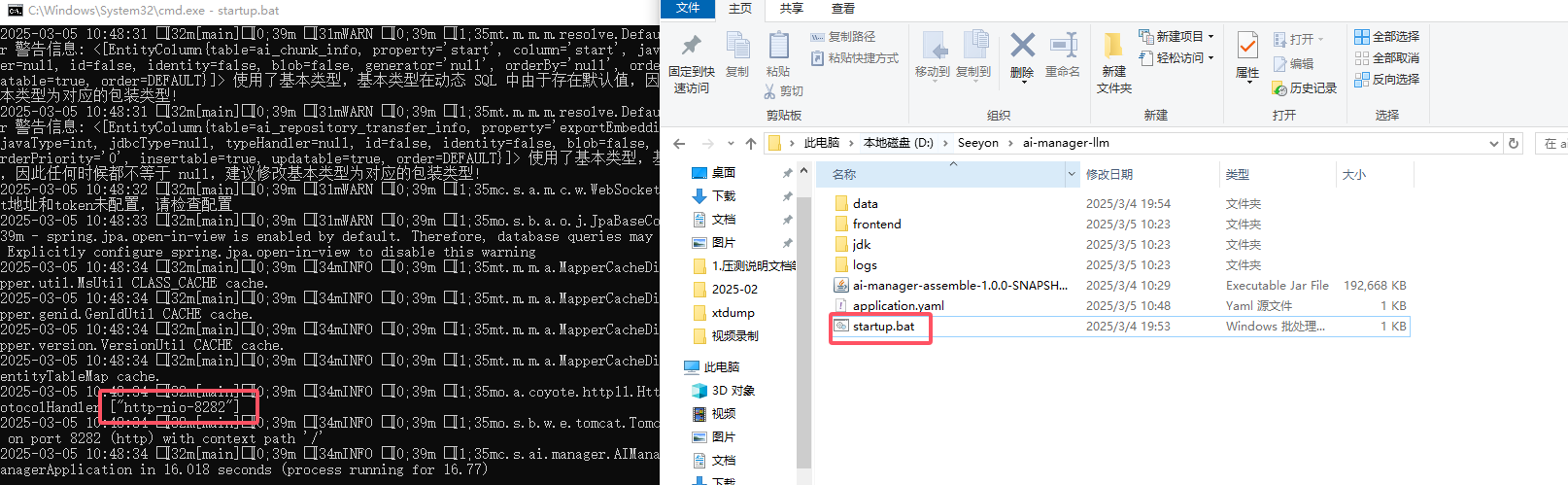

# Win启动服务

进入解压后的模型管理服务目录,执行 startup.bat 脚本以启动模型管理服务。

# 模型管理-访问并配置

Linux或Windows部署模型管理服务成功后,客户端电脑通过浏览器访问http://模型管理服务器IP:端口(默认8282)打开模型管理后台服务管理页面,此页面用于配置介入的大模型信息。

注意确保配置大模型参数的客户端能访问到模型管理服务对应IP和端口,建议仅内部网络客户端访问,以确保服务的基本安全

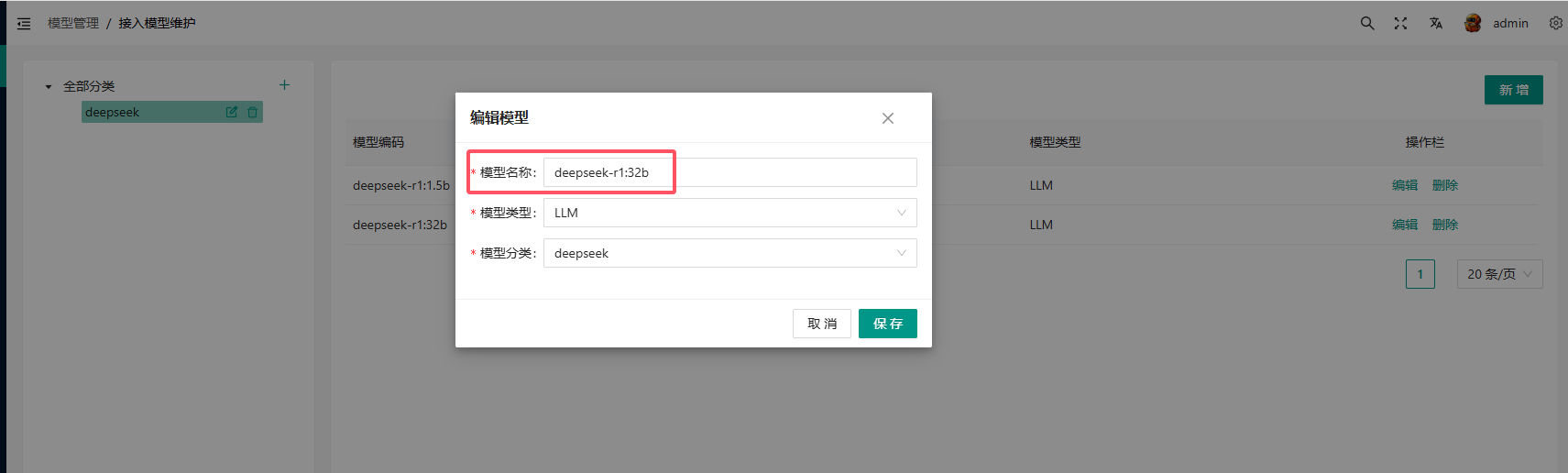

点击模型管理-接入模型维护,首先新建分类:

注意:当使用微软云厂商提供的大模型,如GPT时,模型分类必须叫做azure,其他厂商大模型不要使用该名称

比如使用deekseek官方模型,新建分类:deepseek

随后,新建模型:

模型名称: 对应大模型真实的名称,获取方法见【准备和测试大模型】章节curl测试和获取模型名称model的案例

模型类型: 选择LLM大语言模型

模型分类: 自动对应新建的分类

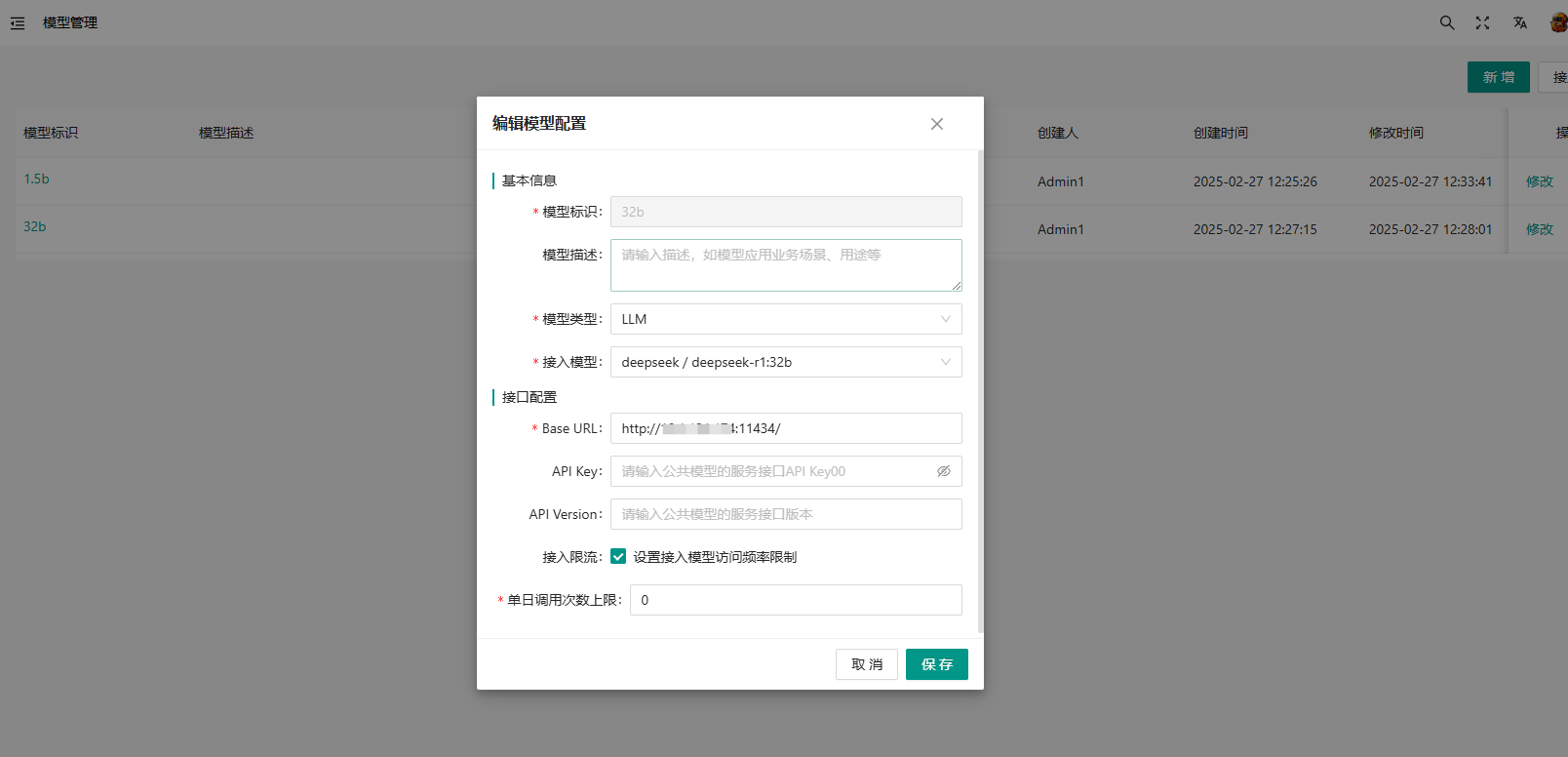

随后,创建模型配置:退回模型管理,点击新增,创建模型配置。

模型标识: 可以自行定义

模型类型: 选择LLM大语言模型

接入模型: 选择前面配置的模型

Base Url: 取大模型的地址(/v1/chat/前面的路径),获取方法见【准备和测试大模型】章节curl测试和获取地址的案例

API Key: 取大模型的API KEY,获取方法见【准备和测试大模型】章节curl测试和获取API KEY的案例,如模型不涉及API KEY则不填写

API Version: 正常情况只有部分公有模型涉及此参数填写,如模型不涉及API Version则不填写

# 模型管理-访问控制和日志管理

确保防火墙允许模型管理的监听端口被协同服务器和配置模型管理的客户端能访问,同时要避免模型管理服务暴露到公网。

如遇模型管理异常,请检查ai-manager-llm/logs日志文件以获取详细的错误信息。

# 三、协同OA部署配置模型对话应用

除了部署模型管理服务之外,协同OA服务需要做如下操作才能使用功能:

# 1、加密狗更新

联系商务购买模型对话插件,并更新加密狗(协同OA程序目录备份base/license/下的加密狗文件,替换为更新后的加密狗文件)

# 2、更新补丁包

向协同办公系统打“模型对话”补丁包,补丁包对各版本BuildID有要求,详细见本手册环境准备章节。

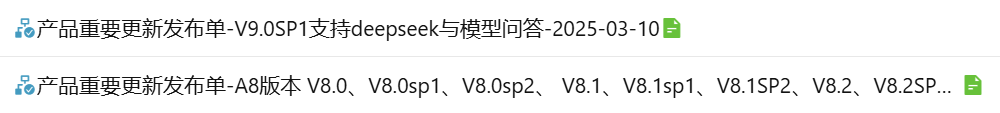

补丁包获取方式:公司协同系统搜索“deepseek”协同标题,找对应版本最新的“产品重要更新发布单”补丁包。

补丁包统一为PAK格式,需要通过S1工具更新补丁到OA上。

# 3、OA接入模型管理服务

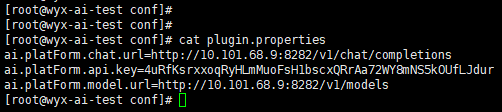

打开OA安装目录下base\conf\plugin.properties文件,文件中手动添加如下配置信息:

注意:修改配置文件后必须重启OA才生效

# 开启AI相关服务

aicoreshell.ai.assistant.enabled=true

# 注意这个参数对应的值与大模型无关,这个对应前面部署的模型管理服务的IP端口信息

ai.platForm.chat.url = http://模型管理服务IP:端口/v1/chat/completions

# 注意这个参数对应的值与大模型无关,这个需要按照下一步手册说明进行操作获取

ai.platForm.api.key = xxx(生成方式查看下述注释)

# 注意这个参数对应的值与大模型无关,这个对应前面部署的模型管理服务的IP端口信息

ai.platForm.model.url = http://模型管理服务IP:端口/v1/models

示例:

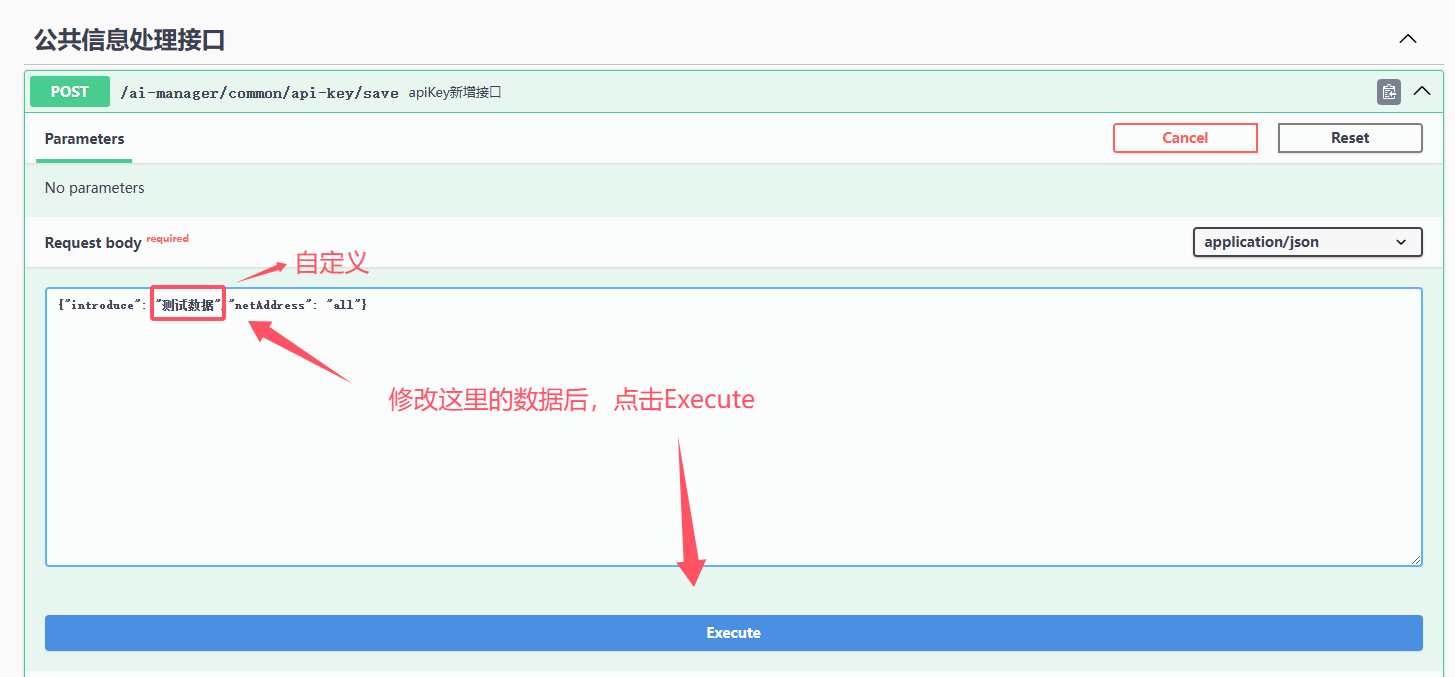

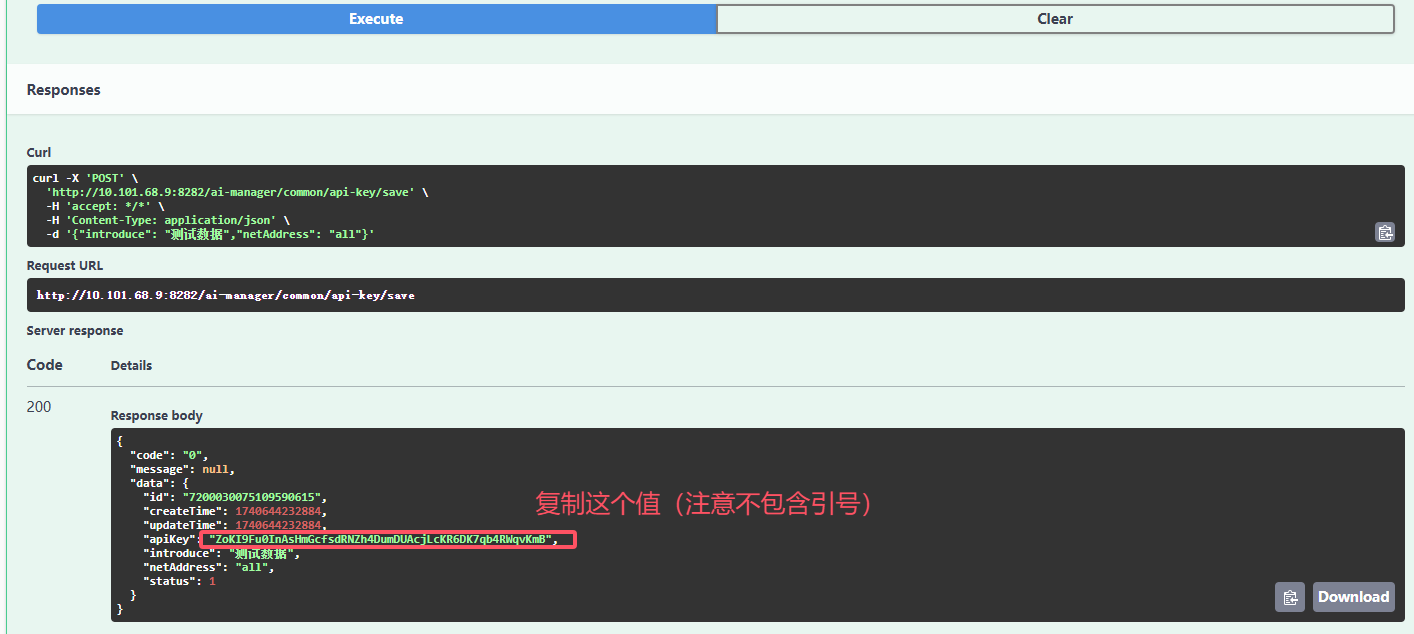

plugin.properties文件中的ai.platForm.api.key生成需要访问http://模型管理服务IP:端口/swagger-ui/index.html#/%E5%85%AC%E5%85%B1%E4%BF%A1%E6%81%AF%E5%A4%84%E7%90%86%E6%8E%A5%E5%8F%A3/save_1,然后点击Try it out

随后,替换Request body下的内容为 {"introduce": "命名(可自定义)","netAddress": "all"}

最后,点击Execute,然后复制下面Responses中的apiKey值。如下图所示:

配置后重新启动OA服务,启动成功后进行下述配置

# 4、协同系统管理员打开模型对话开关

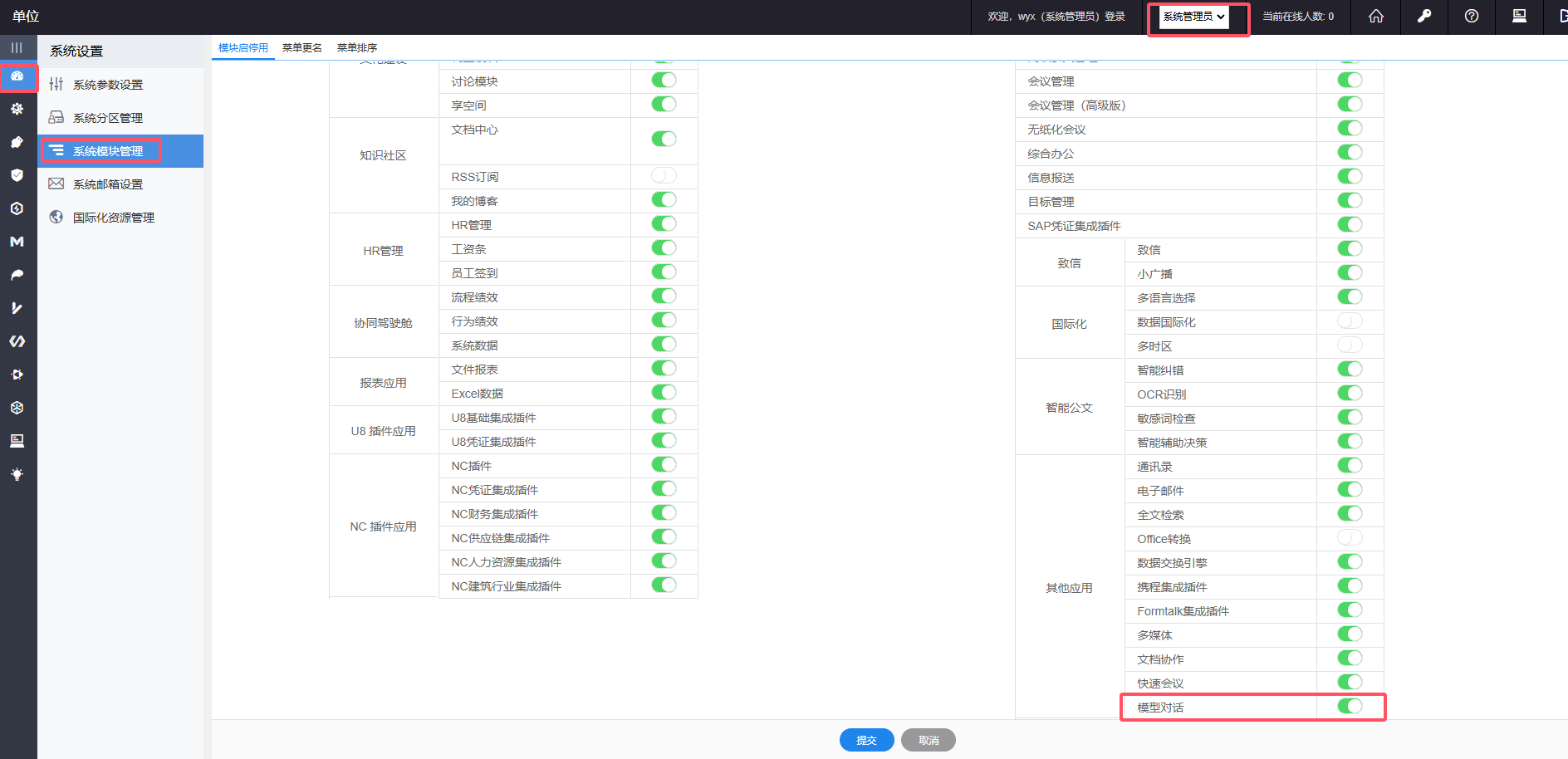

以上完成之后启动协同OA,启动之后系统管理员-系统模块管理,勾选开启模型对话开关,注意保存之后必须重启一次协同OA才彻底生效:

最后参考产品使用手册(商务公布的安装程序下载地址-文档-操作手册-V9.0sp1 新特性手册),完成单位管理员授权后才能正常使用

手册参考位置如图:

# 5、模型名称自定义(非必须)

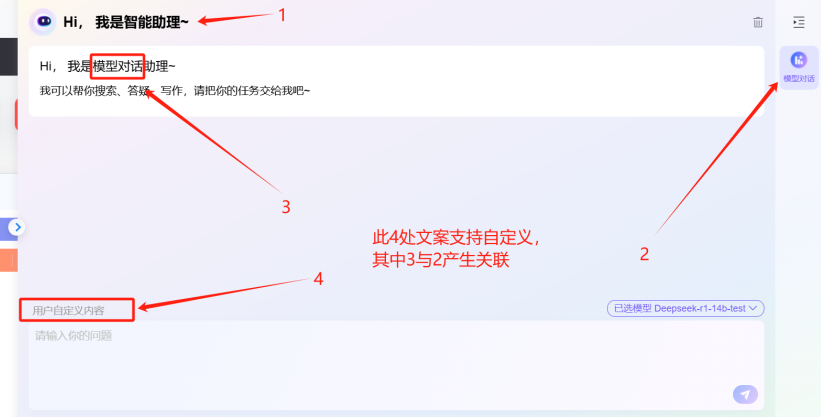

如果客户想要调整面板中的一些名称,可以通过系统管理员-国际化资源管理搜索如下国际化Key并自定义调整内容:

| 序号 | 国际化Key值 | 对应可自定义内容 | 默认值 |

|---|---|---|---|

| 1 | ai.top.page.title | 智能助理名称 | 智能助理 |

| 2 | ai.model.chat | 右侧页签名称 | 模型对话 |

| 3 | ai.user.definition.content | 对话框上方自定义内容 | 用户自定义内容 |

# 6、功能测试

以上全部完成后,使用普通用户登录系统测试功能是否正确:

PC端主界面:

通过登录WebOA后,点击右下角智能助理悬浮窗,展开智能助理侧边栏,具体效果详见下图。

移动端主界面:

打开M3 APP登录后点击右下角智能助理悬浮窗,进入智能助理对话页,具体效果详见下图。

# 常见问题排查步骤

如果发现部署了模型对话,功能不可用,通用的排查步骤就是:

1、参考“准备和测试大模型”章节,先在模型管理服务器执行curl命令测试大模型是否连通,没有通就先解决连通问题

2、参考“模型部署”章节,检查模型名称、base url、api key填写是否准确,一定要基于第1步curl命令中的内容填写

3、参考“OA接入模型管理服务”章节,检查base\conf\plugin.properties配置文件是否按照手册要求进行配置

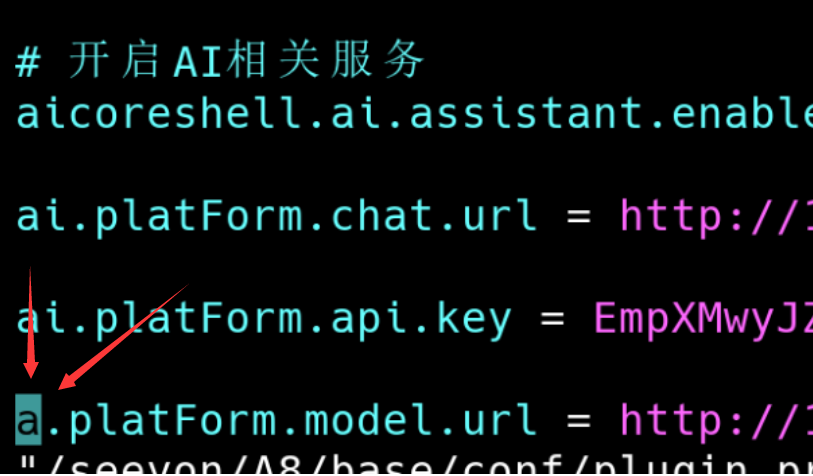

比如,如下问题就是plugin.properties文件中原本应该填写ai.xxx,但实际录入的是a.xxx,参数配置错误:

4、检查网络连通性,确保OA能telnet到模型管理服务IP和端口

← 什么是AI模型对话 智能助理部署配置手册 →